Stable Diffusion의 논문 제목은 High-Resolution Image Synthesis with Latent Diffusion Models다. (링크)

저자는 Robin Rombach, Andreas Blattmann, Dominik Lorenz, Patrick Esser, Björn Ommer다.

논문 Github: 링크

Stable Diffusion Web UI Gihub: 링크

Stable Diffusion은 전에 헤어 스타일 생성 하는데 Stable Diffusion Web UI를 써본적이 있어서 잠깐 봤던 모델인데 논문을 보면서 다시 정리해본다. 그때 Control Net을 썼는데 이 모델도 리뷰 해야겠다.

Abstract

이미지 형성 과정을 denoising autoencoder의 sequential application으로 분해함으로써, diffusion model (DM) 확산 모델은 이미지 데이터 및 그 외 다양한 데이터에 대해 SOTA 합성 결과를 달성했다. 또한 DM은 이미지의 보유 없이 이미지 생성 과정을 제어할 수 있는 가이드 메커니즘을 제공한다. 그러나 이러한 모델은 일반적으로 pixel space 픽셀 공간에서 직접 작동하기 때문에 강력한 DM의 최적화에는 수백 GPU 일이 소요되고, sequentail evaluation 순차적 평가로 인해 추론 비용이 높다. 제한된 계산 리소스에서 DM의 품질과 유연성을 유지하면서 DM을 학습시키기 위해, 본 연구에서는 강력한 사전 학습된 오토인코더의 latent space 잠재 공간에 DM을 적용한다. 이전 연구들과는 달리 표현에 대한 DM의 학습을 통해 복잡성 감소와 디테일 보존 사이의 최적에 가까운 지점에 도달하여 visual fidelity 시각적 충실도를 크게 향상시킬 수 있었다.

모델 아키텍처에 cross-attention layers 크로스 어텐션 레이러를 도입함으로써 확산 모델을 텍스트 또는 bounding boxes와 같은 일반적인 conditioing inputs 컨디셔닝 입력을 위한 강력하고 유연한 generators 생성기로 전환하며 CNN 방식으로 고해상도 합성을 가능하게 한다. 저자들의 Latent Diffusion Model (LDM) 잠재 확산 모델은 image inpainting 및 class-conditional image synthesis 클래스 조건부 이미지 합성에서 SOTA 점수를 달성했으며, text-to-image 합성, unconditional image synthesis 그리고 super-resolution 초고해상도를 포함한 다양한 작업에서 매우 경쟁력 있는 성능을 제공하면서도 픽셀 기반 DM에 비해 계산 요구 사항을 크게 줄였다.

1. Introduction

Departure to Latent Space

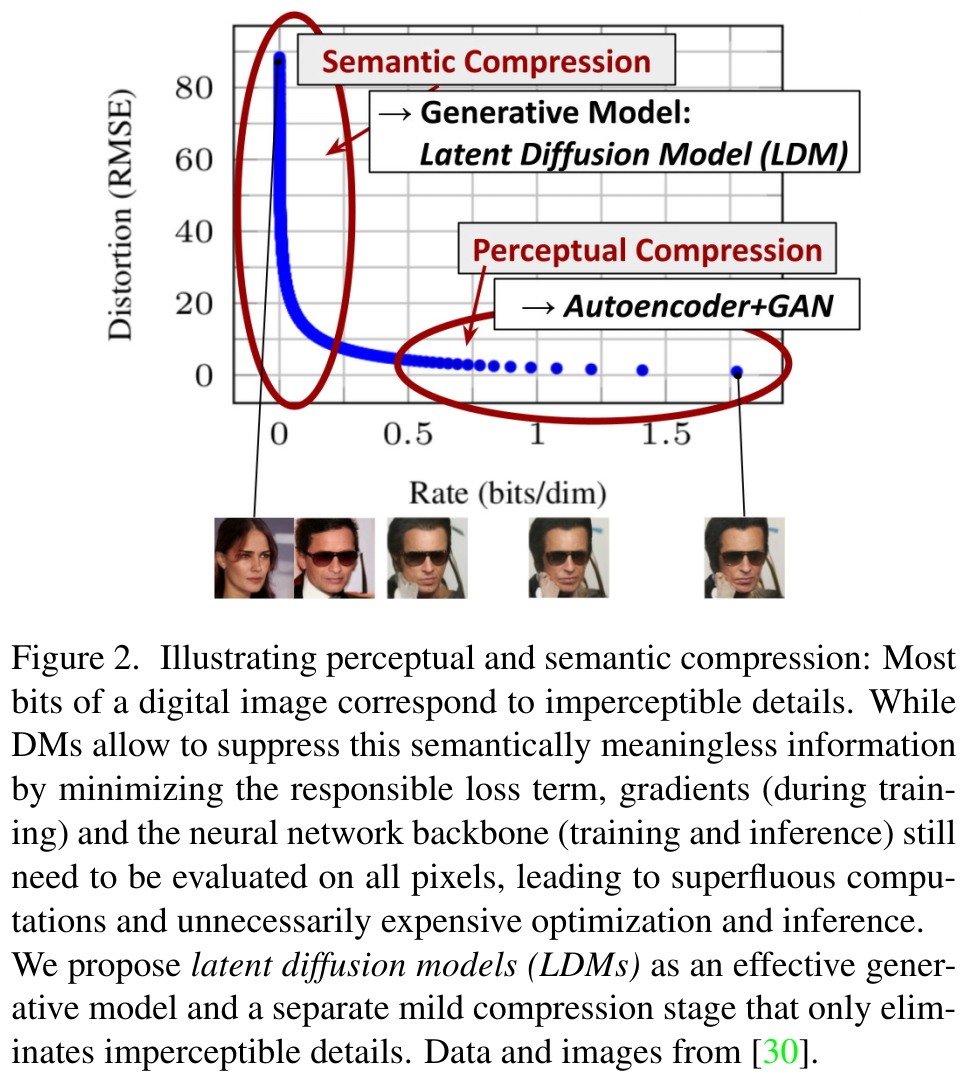

저자들의 접근 방식은 이미 픽셀 공간에서 훈련된 확산 모델을 분석하는 것으로 시작한다. 아래 Figure 2는 훈련된 모델의 rate-distortion trade-off 비율-왜곡 트레이드오프를 보여준다. 여러가지 likelihood-based model 우도 기반 모델들과 마찬가지로, 학습은 크게 두 단계로 나눌 수 있다.

첫 번째는 perceptual compression 지각적 압축 단계로, 고주파수 디테일을 제거하면서도 semantic 의미론적 변화는 거의 학습하지 않는다. 두 번째 단계에서는 실제 생성 모델이 데이터의 semantic and conceptual composition 의미론적 및 개념적 구성을 학습한다 (semantic compression 의미론적 압축). 따라서 저자들은 고해상도 이미지 합성을 위한 확산 모델을 훈련할 수 있는, 지각적으로는 동등하지만 계산적으로 더 적합한 공간을 먼저 찾는 것을 목표로 한다.

일반적인 관례에 따라, 저자들은 훈련을 두 개의 명확한 단계로 분리합니다. 첫째, 데이터 공간과 지각적으로 동등하면서도 낮은 차원 (따라서 효율적인)의 representation space 표현 공간을 제공하는 오토인코더를 훈련한다. 중요한 점은 이전 연구와 달리, 본 연구는 과도한 공간 압축에 의존할 필요가 없다. 학습된 잠재 공간에서 확산 모델 (DM)을 훈련하기 때문인데, 이 잠재 공간은 공간적 차원에 대해 더 나은 스케일링 속성을 보여준다. 복잡도의 감소는 또한 single network pass만으로 잠재 공간에서 효율적인 이미지 생성을 가능하게 한다. 그 결과는 Latent Diffusion Models (LDM) 잠재 확산 모델이라고 명명한다.

이 접근 방식의 주목할 만한 장점은 universal autoencoding stage를 한 번만 훈련하면 된다는 점이다. 따라서 여러 DM 훈련에 재사용하거나, 완전히 다른 태스크를 탐색하는 데 활용할 수 있다. 이는 다양한 Image-to-image 및 Text-to-image 태스크를 위한 수많은 확산 모델을 효율적으로 탐색할 수 있게 만든다. 후자의 경우 (Text-to-image ), 트랜스포머를 DM의 UNet 백본에 연결하고 모든 유형의 토큰 기반 조건화 메커니즘을 가능하게 하는 아키텍처를 설계했다 (섹션 3.3 참조).

3. Method

High-resolution 고해상도 이미지 합성을 위한 확산 모델 학습의 계산적 요구 사항을 낮추기 위해, 저자들은 확산 모델이 해당 손실 항을 언더샘플링하여 perceptually 지각적으로 irrelavant details 무관한 세부 사항을 무시할 수 있도록 허용하지만 여전히 픽셀 공간에서 비용이 많이 드는 함수 평가가 필요하기 때문에 계산 시간과 에너지 리소스가 엄청나게 소모된다는 것을 관찰했다.

저자들은 compressive learning 압축 학습과 generative learning phase생성 학습 단계를 명시적으로 분리하여 이러한 단점을 우회하는 것을 제안한다 (아래 Figure 2 참조). 이를 위해 이미지 공간과 지각적으로 동일한 공간을 학습하지만 계산 복잡도를 크게 줄이는 autoencoding 모델을 활용한다.

이러한 접근 방식은 여러 가지 장점을 갖는다.

(i) 고차원 이미지 공간을 남겨둠으로써 샘플링이 저차원 공간에서 수행되기 때문에 계산적으로 훨씬 더 효율적인 DM을 얻는다.

(ii) UNet 아키텍처에서 상속받은 DM의 inductive bias 귀납적 편향을 활용한다. 이는 spatial structure 공간 구조가 있는 데이터에 특히 효과적이며 따라서 이전 접근 방식들에서 요구하는 공격적이고 품질을 저하시키는 압축 수준에 대한 필요성을 완화한다.

(iii) 마지막으로, 잠재 공간을 사용하여 여러 생성 모델을 훈련할 수 있고 단일 이미지 CLIP-guided 합성과 같은 다른 다운스트림 응용에도 활용할 수 있는 general compression models 범용 압축 모델을 얻는다.

전반적인 구조는 아래 Figure 3와 같다.

전반적인 흐름은 아래와 같다.

원본 이미지 $x$ → $x$에 AE의 인코더 적용 → latent representation $z$ → Noise를 추가하는 Diffusion Process → $z_T$ → Conditioning된 입력 $y$의 중간 표현 $\tau_\theta(y)$ 준비 → Denoising U-Net과 크로스 어텐션으로 $\tau_\theta(y)$의 피쳐를 활용하여 $z_T$를 $z$로 복원 → 복원된 $z$에 AE의 디코더 적용 → 복원된 이미지 $\tilde{x}$

3.1. Perceptual Image Compression

저자들의 perceptual compression model 지각 압축 모델은 이전 연구 (VQGAN, Taming Transformers for High-Resolution Image Synthesis 링크)를 기반으로 하며 preceptual loss와 path-based adverarial objective의 조합으로 학습된 Autoencoder (이하 AE)로 구성된다.이는 local realism 로컬 사실주의를 강화하여 reconsturciotns 재구성이 image manifold 이미지 매니폴드로 제한되도록 하고 L2 또는 L1 목적함수와 같은 픽셀 공간 로스에만 의존하여 발생하는 bluriness 흐릿함을 방지한다.

더 정확하게는 RGB 공간에서 이미지 $x \in \mathbb{R}^{H \times W \times 3}$가 주어지면 인코더 $\mathcal{E}$은 $x$를 latent representation 잠재 표현 $z = \mathcal{E} (x)$로 인코딩하고 디코더 $\mathcal{D}$는 잠재 표현에서 이미지를 재구성하여 $\tilde{x} = \mathcal{D}(z) = \mathcal{D}(\mathcal{E}(x))$를 얻는다.여기서 $z \in \mathbb{R}^{h \times w \times c}$다.. 중요한 점은 바로 인코더가 이미지를 $f = H/h = W/w$ factor로 다운샘플링한다는 점이며, 저자들은 $m \in \mathbb{N}$인 다양한 다운샘플링 팩터 $f = 2 m$을 조사한다.

임의의 높은 분산의 잠재 공간을 피하기 위해 두 가지 유형의 regularizations 정규화를 실험한다.

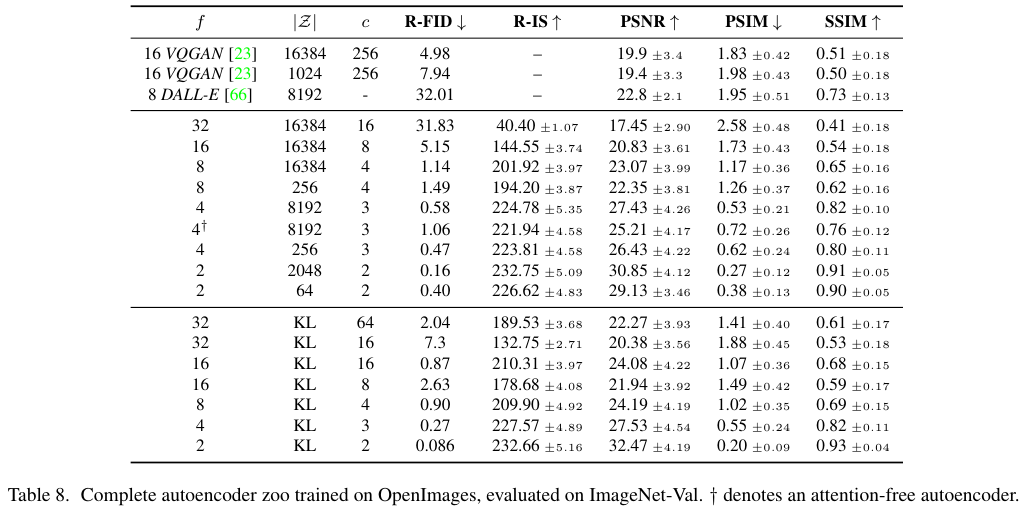

첫 번째 변형은 KL-reg.로 VAE (Variational AutoEncoder)와 유사하게 학습된 잠재 공간의 표준 정규분포에 대한 약간의 KL 페널티를 부과한다. 반면에 VQ-reg.는 디코더 내에 벡터 양자화 레이어를 사용한다. 이 모델은 VQGAN으로 해석할 수 있지만 양자화 레이러는 디코더에 의해 흡수된다. 저자들의 후속 DM은 학습된 잠재 공간 $z = \mathcal{E} (x)$의 2차원 구조로 작동하도록 설계되었으므로 비교적 낮은 압축률을 사용하고 매우 우수한 재구성을 얻을 수 있다. 이는 학습 공간 $z$의 임의의 1D ordering 1차원 순서에 의존하여 분포를 autoregressively 자기회귀적으로 모델링한다. 따라서 $z$의 inferent structure 내재적 구조를 상당 부분 무시했던 이전 연구들과 대조적이다. 따라서 본 압축 모델은 x의 details 세부 정보를 더 잘 보존한다 (아래 Table 8 참조). Full objective 및 학습 세부 정보는 supplement에서 확인할 수 있다.

3.2. Latent Diffusion Models

Diffusion Models

확산 모델은 정규 분포 변수의 잡음을 점진적으로 제거하여 데이터 분포 $p(x)$를 학습하도록 설계된 확률적 모델로, 길이가 $T$인 고정 마르코프 체인의 역과정을 학습하는 것과 같다. 이미지 합성의 경우, 가장 성공적인 모델들 (DDIM, DDPM, SR3)은 $p(x)$의 variational lower bound의 reweighted variant 재가중치 변형에 의존하며 이는 denoising score-mathcing 잡음 제거 점수 매칭을 반영한다.

이러한 모델들은 디노이징 $\epsilon_{\theta} (x_t, t)$; $t = 1 . . . T$ 의 동일 가중치 시퀀스로 해석할 수 있으며, 이는 입력 $x_t$ 의 디노이징 변형을 예측하도록 학습된다. 여기서 $x_t$ 는 입력 $x$의 잡음이 삽입된 버전을 의미한다. 이에 해당하는 목적 함수는 해당 목표는 다음 (1)과 같이 단순화할 수 있다. (자세한 내용은 섹션 B 참조).

$L_{DM} = \mathbb{E}_{\epsilon ~ N(0, 1), t} [ || \epsilon - \epsilon_\theta (x_t, t)||_2^2 ]$ ... (1)

이때 $t$는 {1, ..., $T$}로 유니폼하게 샘플링된다.

Generative Modeling of Latent Representations

인코더 $\mathbb{E}$와 디코더 $\mathbb{D}$로 구성되는 학습된 지각 압축 모델들을 통해서, high-frequency 고주파의 imperceptible details 인지불가능한 세부 정보를 추상화된 효율적인 저차원 잠재 공간에 접근할 수 있게 되었다. 고차원 픽셀 공간에 비해 이 공간은 likelihood 기반 생성 모델에 더 적합하다.이 모델은 (i) 데이터의 중요한 의미적 비트에 집중하고 (ii) 계산적으로 훨씬 더 효율적인 저차원 공간에서 학습될 수 있기 때문이다.

고도로 압축된 discrete latent space 이산 잠재 공간에서 autoregressive attention-based transformer 모델에 의존했던 이전 연구들과 달리, 본 모델이 제공하는 image-specific inductive biases 이미지별 귀납적 편향을 활용할 수 있다. 이는 2D 컨볼루션 레이어가 주된 구조인 근본적인 UNet을 구축하고, 추가적으로 reweighted bound 재가중치 경계를 사용하여 perceptually 지각적으로 가장 관련성 있는 bits 비트에 목적 함수를 더욱 집중하는 기능을 포함한다. 그 목적함수는 아래 (2)다.

$L_{LDM} = \mathbb{E}_{\epsilon ~ N(0, 1), t} [ || \epsilon - \epsilon_\theta (z_t, t)||_2^2 ]$ ... (2)

본 모델의 신경망 백본 $ \epsilon_\theta (\circ, t)$는 time-conditonal 시간 조건부 UNet으로 구현된다. 순방향 프로세스가 고정되어 있으므로 학습 중에 $\mathbb{E}$에서 $z_t$를 효율적으로 얻을 수 있으며, $p(z)$의 샘플은 $\mathbb{D}$를 single pass 한 번 통과하여 이미지 공간으로 디코딩될 수 있다.

3.3. Conditioning Mechanisms

다른 유형의 생성 모델들 (GAN, CGM)과 유사하게, 확산 모델은 원칙적으로 $p(z|y)$ 형태의 조건부 분포를 모델링할 수 있다. 이는 디노이징 AE $ \epsilon_\theta (z_t, t, y)$로 구현할 수 있으며 텍스트,semantic maps 의미 맵 또는 기타 image-to-image translation task와 같은 입력 $y$를 통해 합성 프로세스를 제어하는 길을 열어준다.

그러나 이미지 합성의 맥락에서 DM의 생성 능력을 클래스 레이블이나 입력 이미지의 blurred variants 흐릿한 변형을 넘어서는 다른 유형의 조건화와 결합하는 것은 지금까지 충분히 탐구되지 않은 연구 분야다.

저자들은 다양한 입력 모달리티의 어텐션 기반 모델을 학습하는 데 효과적인 크로스 어텐션 메커니즘으로 기본 UNet 백본을 보강하여 DM을 보다 유연한 조건부 이미지 생성기로 전환한다. 다양한 모달리티(예: 언어 프롬프트)에서 $y$를 전처리하기 위해 $y$를 intermediate representation 중간 표현 $\tau_\theta (y) \in \mathbb{R}^{M \times d_\tau}$ 프로젝션하는 도메인별 인코더 $\tau_\theta$를 도입한다. 이 표현은 Attention(Q, K, V) = softmax( $ \frac{ QK^\top }{ \sqrt{d} } \cdot V $ )다.

이때, $Q =W_Q^{(i)} \cdot \psi_i(z_t), K =W_K^{(i)} \cdot \tau_\theta(y), V =W_V^{(i)} \cdot \tau_\theta(y)$다.

그리고 $\psi_i(z_t) \in \mathbb{R}^{N \times d_e^i}$로 Unet의 flattened intermediate representation다.

이때 UNet은 $\epsilon_\theta$을 구현하는 $W_V^{(i)} \in \mathbb{R}^{d \times d_e^i}$, 그리고 $W_Q^{(i)}, W_K^{(i)} \in \mathbb{R}^{d \times d_\tau}$을 가진다. 위 3가지 행렬들은 모두 learnable 파라미터다.

$L_{LDM} = \mathbb{E}_{\mathcal{E}(x), y, \epsilon ~ N(0, 1), t} [ || \epsilon - \epsilon_\theta (z_t, t, \tau_\theta (y))||_2^2 ]$ ... (3)

$\tau_\theta$와 $\epsilon_\theta$을 방정식 (3)을 통해서 동시에 최적화한다. 이러한 조건화 메커니즘은 domain-specific experts, (e.g., (unmasked) transformers $y$가 텍스트 프롬프트,로 파라미터화 되는 $\tau_\theta$에 의해서 유연하게 작동한다.

4. Experiments

LDM은 다양한 이미지 모달리티에 대해 유연하고 계산적으로 처리 가능한 확산 기반 이미지 합성 수단을 제공하며 아래에서 경험적으로 보여준다.

4.1. On Perceptual Compression Tradeoffs

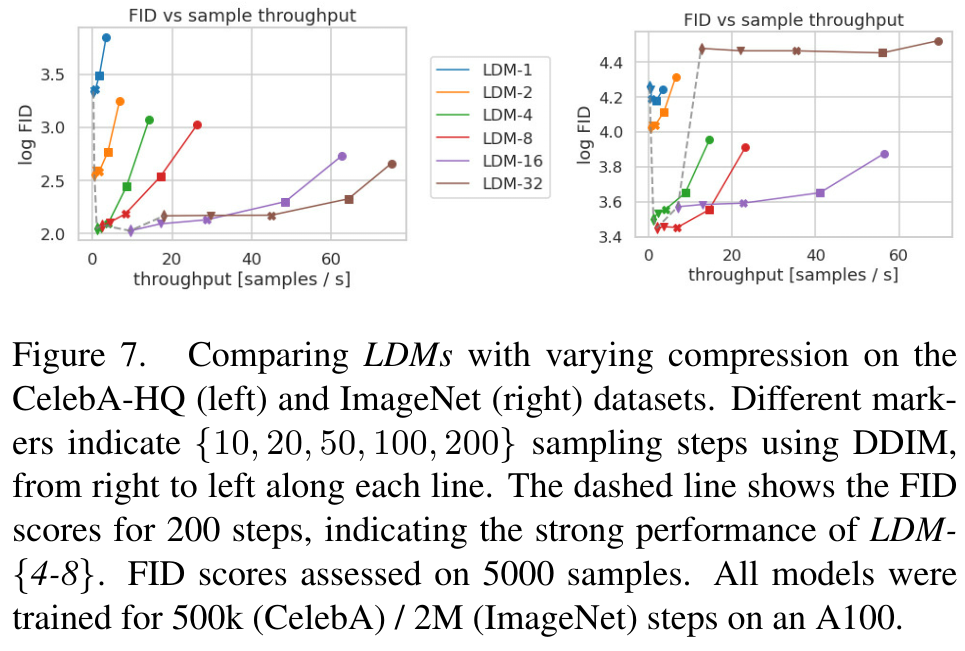

이 섹션에서는 다양한 다운샘플링 팩터 $f$ {1, 2, 4, 8, 16, 32} (LDM-$f$로 표기, 이때 LDM-1은 픽셀 기반 DM에 해당) 를 갖는 LDM의 성능을 분석한다. 비슷한 테스트 필드를 얻기 위해 이 섹션의 모든 실험에 대해 계산 리소스를 단일 NVIDIA A100에 고정하고 동일한 단계 수와 동일한 매개변수 수로 모든 모델을 학습시킨다.

위에서 제시한 Table 8은 이 섹션에서 비교한 LDM에 사용된 1단계 모델의 하이퍼파라미터와 재구성 성능을 보여준다. 아래 Figure 6은 ImageNet 데이터셋에서 클래스 조건부 모델의 2M steps에 대한 학습 진행률의 함수로서 샘플 퀄리티를 보여준다. i) LDM-{1,2}에 대한 작은 다운샘플링 팩터는 학습 진행을 느리게 하는 반면, ii) 지나치게 큰 f 값은 비교적 적은 학습 단계 후에 fidelity가 정체되는 것을 볼 수 있다.

위의 분석(그림 1 및 2)을 다시 살펴보면, 이는 i) 대부분의 perceptual 지각적 압축을 확산 모델에 맡기고 ii) 너무 강한 1단계 압축으로 정보 손실이 발생하여 달성 가능한 품질이 제한되기 때문이라고 생각한다. LDM-{4-16}은 효율성과 지각적으로 충실한 결과 사이에서 적절한 균형을 이루며, 이는 2M 학습 단계 후 픽셀 기반 확산(LDM-1)과 LDM-8 간에 38의 상당한 FID (Fréchet Inception Distance) 격차로 나타난다.

위 Figure 7에서는 DDIM 샘플러를 사용하여 다양한 노이즈 제거 단계에 대한 샘플링 속도 측면에서 CelebAHQ와 ImageNet에서 학습된 모델을 비교하고 FID 점수를 그래프로 표시한다. LDM-{4-8}은 perceptual 지각적 압축과 conceptual 개념적 압축 비율이 적합하지 않은 모델보다 성능이 뛰어나다. 특히 픽셀 기반 LDM-1과 비교할 때 샘플 처리량을 크게 증가시키면서 동시에 훨씬 낮은 FID 점수를 달성한다. ImageNet과 같은 복잡한 데이터셋은 품질 저하를 방지하기 위해 압축률을 낮춰야 한다. 요약하자면, LDM-4와 -8은 고품질 합성 결과를 얻는 데 가장 적합한 조건을 제공한다.

여기서 말한 perceptual compression은 Autoencoder가 더 작은 차원으로 latent representation을 배우는 과정을 의미한다.

Conceptual compression은 semantic과 관련된 내용으로 high-level의 디테일을 의미한다.

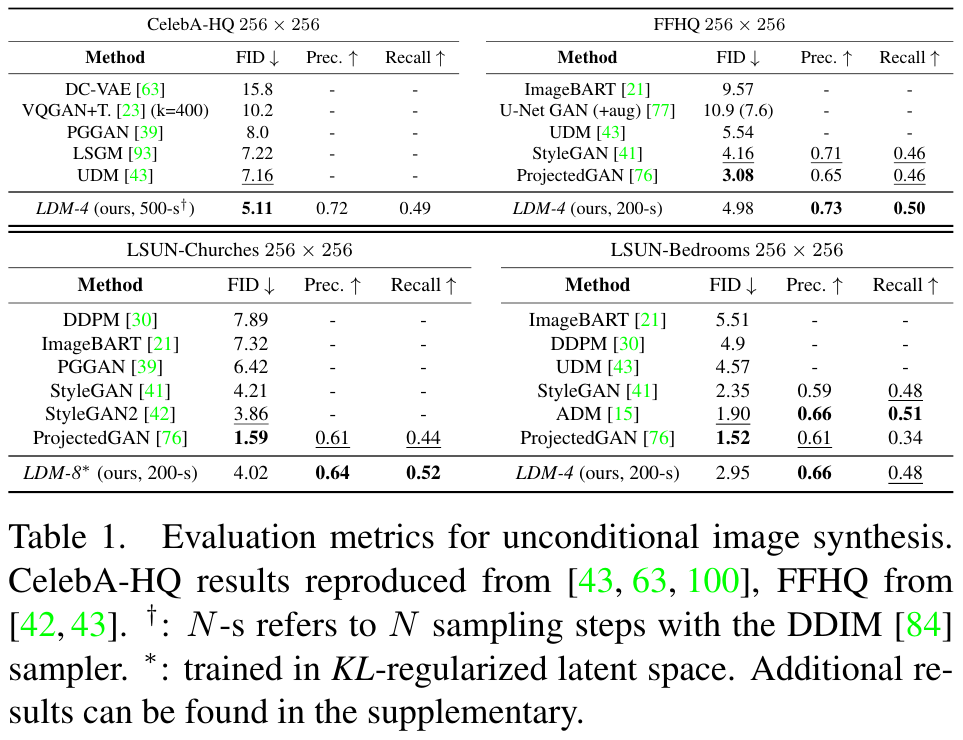

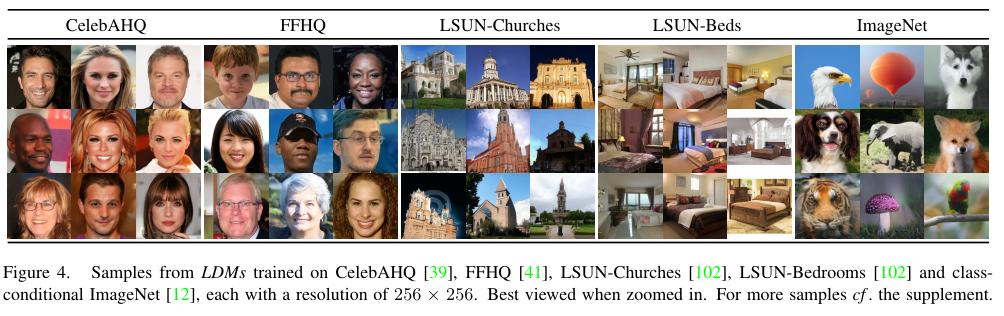

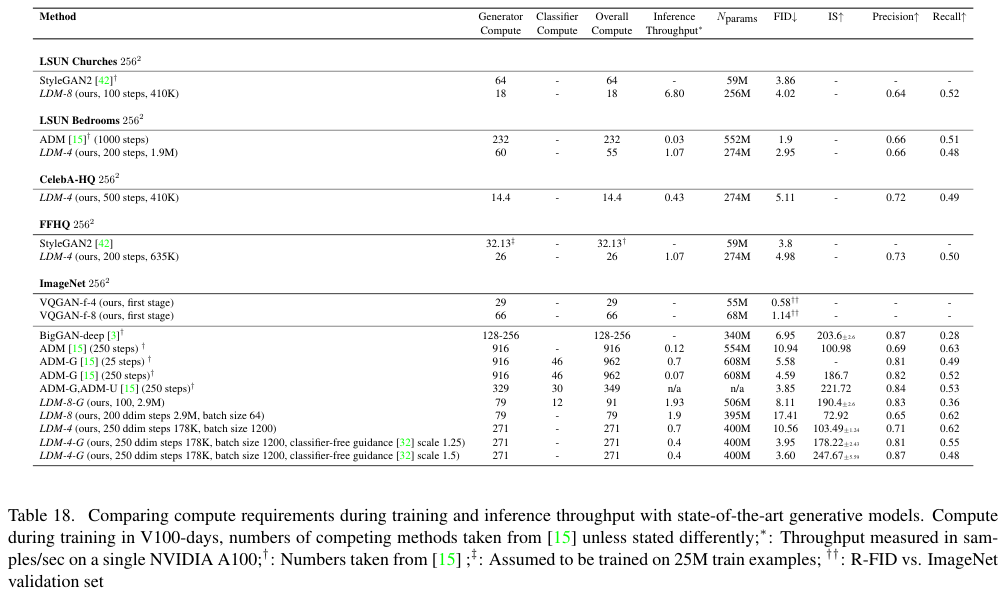

4.2. Image Generation with Latent Diffusion

저자들은 CelebA-HQ, FFHQ , LSUN-Churches and -Bedrooms 에서 256개의 2개 이미지의 무조건 모델을 훈련하고 ii) FID 와 ii) Precision-and-Recall을 사용하여 i) 샘플 품질과 ii) 데이터 매니폴드의 적용 범위를 평가한다. 아래 Table 1에 결과가 요약되어있다.

CelebA-HQ에서 저자들은 5.11의 최신 FID를 보고하며, 이는 이전의 likelihood 우도 기반 모델과 GAN보다 우수한 성능이다.또한 LDM이 첫 번째 단계와 함께 공동으로 훈련되는 LSGM 보다 우수한 성능을 보인다. 반대로, 저자들은 fixed space 고정된 공간에서 확산 모델을 훈련하여 잠재 공간과 재구성 품질에 대한 사전 학습의 가중치를 맞추는 어려움을 피한다(위에서 제시된 Figure 1-2 참조).

저자들은 매개변수의 절반을 활용하고 4배 적은 훈련 리소스를 필요로 함에도 불구하고 점수가 ADM에 가까운 LSUN-Bedrooms 데이터셋을 제외한 모든 데이터셋에서 이전의 확산 기반 접근 방식들보다 우수한 성과를 보였다(Appendix E.3.5 참조).

더 나아가, LDM은 GAN 기반 방법보다 정밀도와 재현율에서 지속적으로 향상되었으며, 이는 adversarial 접근법들에 비해 mode-covering likelihood 우도 기반 훈련 목표가 가진 장점을 입증한다. 각 데이터셋의 결과는 아래 Figure 4에 제시된다.

4.3. Conditional Latent Diffusion

4.3.1 Transformer Encoders for LDMs

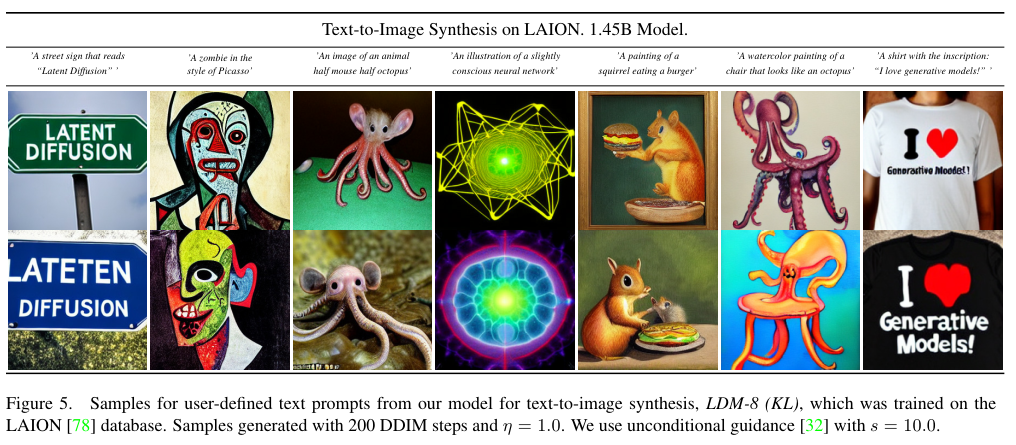

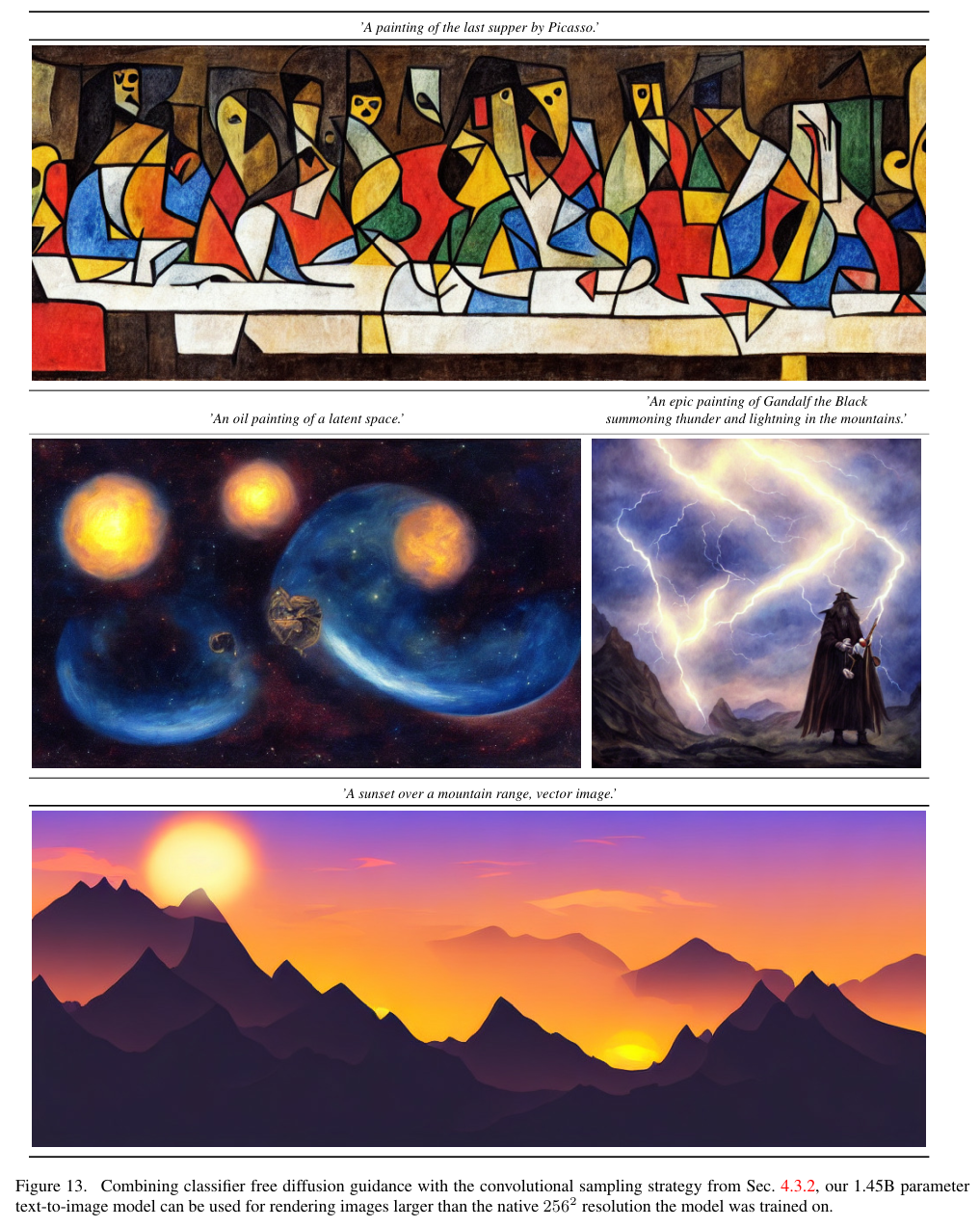

교차 어텐션(cross-attention) 기반의 조건화(conditioning)를 LDM에 도입함으로써, 확산 모델에서는 이전에 탐색되지 않았던 다양한 조건화 방식들을 활용할 수 있게 되었다. Text-to-image 모델링을 위해, LAION-400M 데이터셋에서 언어 프롬프트로 조건화된 1.45B 파라미터의 KL-regularized LDM을 훈련시켰다. BERT 토크나이저를 사용하고, $\tau_\theta$를 트랜스포머로 구현하여 UNet으로 (멀티 헤드) 크로스 어텐션을 통해 매핑되는 latent code를 추론했다 (섹션 3.3). Language representation 언어 표현 학습을 위한 domain specific experts 도메인별 전문가와 visual synthesis 시각적 합성의 조합은 강력한 모델을 탄생시켰으며, 이 모델은 복잡하고 사용자가 정의한 텍스트 프롬프트에 잘 일반화된다. (아래 Figure 8와 5 참조)

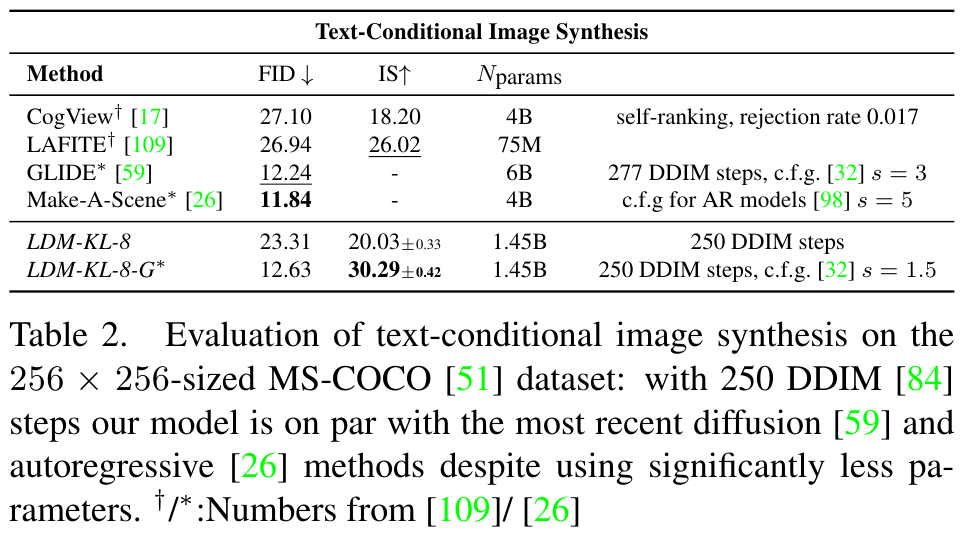

기존 연구를 따라 MS-COCO validaiton 검증 세트에서 Text-to-image 생성을 평가했다. LDM 모델은 강력한 AR (Autoregressive) 및 GAN 기반 방법들을 능가했다 (아래 Table 2 참조). Classifier-free diffusion guidance를 적용하면 샘플 품질이 크게 향상되어, 가이드된 LDM-KL-8-G가 Text-to-image 합성을 위한 최신 AR 및 확산 모델과 동등한 수준에 도달하면서도 파라미터 수는 상당히 줄어든다. 크로스 어텐션 기반 조건화 메커니즘의 유연성을 추가로 분석하기 위해, OpenImages 에서 semantic layouts 의미론적 레이아웃을 기반으로 이미지를 합성하는 모델을 훈련하고 COCO에서 finetune 했다 (위의 Figure 8 참조). 평가 및 구현 세부 사항은 섹션 D.3을 참조하십시오.

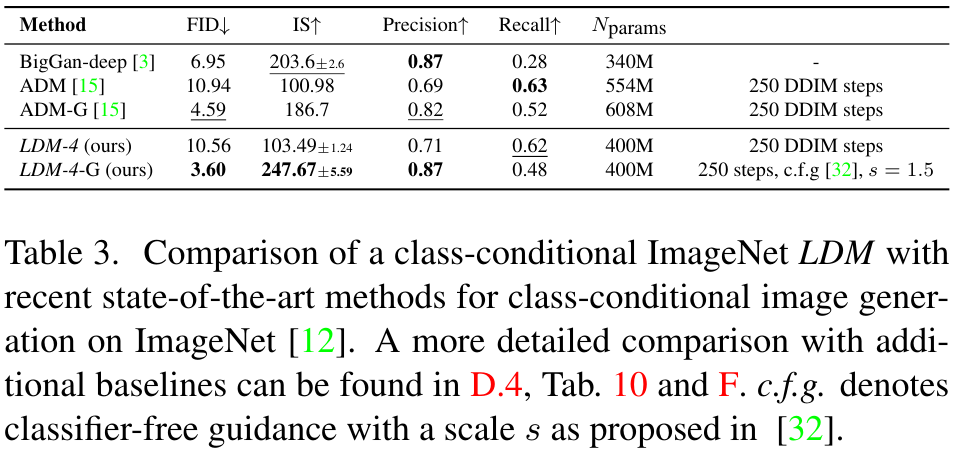

마지막으로, 기존 연구를 따라, 섹션 4.1의 가장 성능이 좋은 클래스-조건부(class-conditional) ImageNet 모델 ($f \in $ {4,8})을 Table 3, Figure 4 및 섹션 D.4에서 평가했다. 여기서 저자들은 최신 확산 모델인 ADM을 능가하면서도 계산 요구 사항과 파라미터 수를 현저히 줄였다 (아래 Table 18 참조).

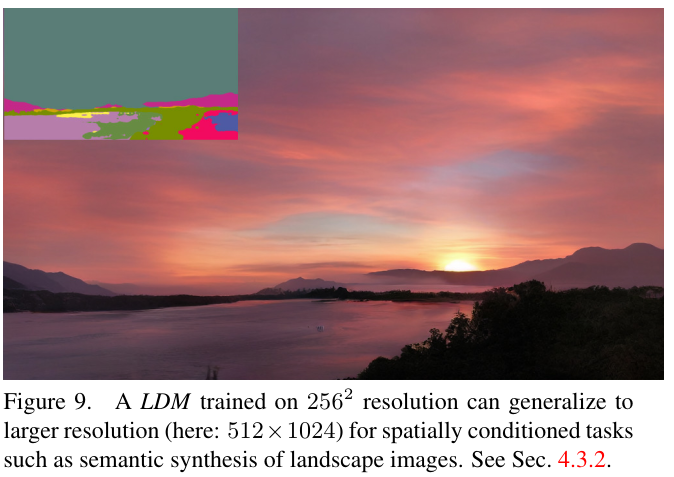

4.3.2 256x256을 넘어서는 합성곱 샘플링

Spatially aligned 공간적으로 정렬된 조건화 정보를 입력 ($\tau_\theta$의 입력에 연결됨)를 concat함으로써, LDM은 효율적인 범용 image-to-image 변환 모델로 기능할 수 있다. 저자들은 이를 활용하여 semantic synthesis 의미론적 합성, super-resolution 초고해상도 (섹션 4.4), 그리고 inpainting 인페인딩 (섹션 4.5)을 위한 모델을 훈련했다. 의미론적 합성을 위해, semantic maps와 쌍을 이루는 풍경 이미지를 사용하고, 다운샘플링된 의미론적 맵 버전을 $f$=4 모델의 잠재 이미지 표현 (VQ-정규화, Table 8 참조)과 연결했다. 256 x 256의 입력 해상도 (384 x 384에서 잘라낸)로 훈련했지만, 저자들은 보다 더 큰 해상도로 일반화되며, 컨볼루션 방식으로 평가될 때 메가픽셀 수준까지 이미지를 생성할 수 있음을 발견했다 (아래 Figure 9 참조). 이 동작을 활용하여 섹션 4.4의 초고해상도 모델과 섹션 4.5의 인페인팅 모델을 512 x 512에서 1024 x 1024 사이의 큰 이미지를 생성하는 데 적용했다. 이 응용 프로그램의 경우, Signal-to-noise ratio 신호 대 잡음비 (잠재 공간의 스케일에 의해 유도됨)이 결과에 크게 영향을 미친다. 섹션 D.1에서 저자들은 (i) $f$=4 모델 (KL-정규화, 위 Table 8 참조)이 생성하는 잠재 공간에서 LDM을 학습할 때, 그리고 (ii) component-wise 구성 요소별 표준 편차로 스케일링된 rescaled version 재조정 버전에서 이를 설명한다.

후자는 classifier-free guidance와 결합되어, 아래 Figure 13에서와 같이 text-conditional LDM-KL-8-G를 위한 > 256 x 256 보다 큰 이미지의 직접적인 합성도 가능하게 한다.

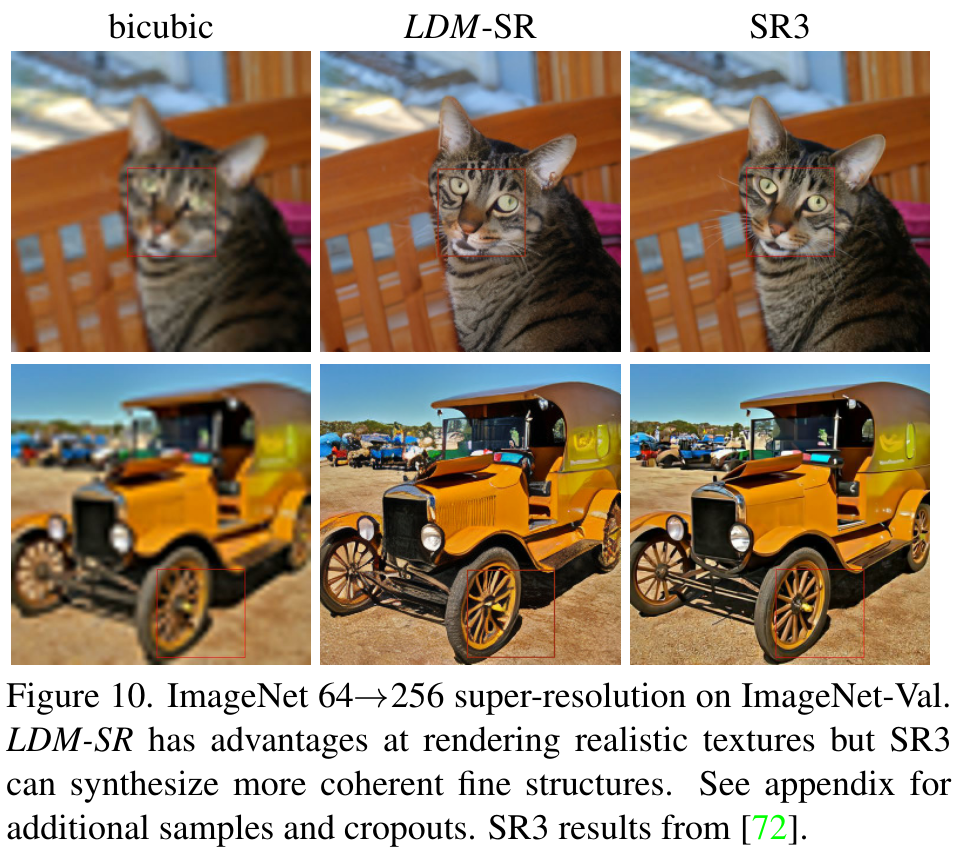

4.4. Super-Resolution with Latent Diffusion

LDM은 저해상도 이미지에 직접 concatenation하는 방식으로 조건화함으로써 super-resolution를 위해 효율적으로 훈련될 수 있다 (섹션 3.3 참조). 첫 번째 실험에서는 SR3를 따라 이미지 degradation 열화를 4배 다운샘플링하는 bicubic interpolation으로 고정하고, SR3의 데이터 처리 파이프라인에 따라 ImageNet에서 훈련했다. OpenImages에서 사전 훈련된 $f$=4 오토인코딩 모델(VQ-정규화, Table 8 참조)을 사용하고, 저해상도 조건화 $y$와 UNet으로의 입력을 concat했습니다 (즉, $\tau_\theta$는 identity 항등 함수다). 결과는 (아래 Figure 10 및 Table 5 참조)는 경쟁력 있는 성능을 보여주며, LDM-SR은 FID에서 SR3를 능가하는 반면 SR3는 더 나은 IS (Inception Score)를 가진다.

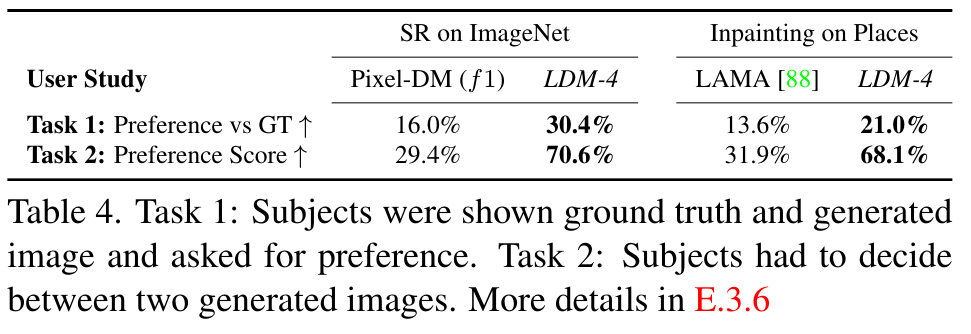

단순한 Image Regression 모델은 가장 높은 PSNR 및 SSIM 점수를 달성하지만, 이 지표들은 인간의 지각과 잘 일치하지 않으며, 불완전하게 정렬된 고주파수 디테일보다는 흐릿함을 선호한다. 또한, 저자들은 픽셀-기준 모델과 LDM-SR을 비교하는 사용자 연구를 수행했다. SR3를 따라, 두 개의 고해상도 이미지 사이에 저해상도 이미지를 보여주고 선호도를 묻는 방식으로 진행했다. 아래 Table 4의 결과는 LDM-SR의 우수한 성능을 확인시켜준다. PSNR과 SSIM은 post-hoc guiding 사후 가이딩 메커니즘을 사용하여 높일 수 있으며, 이 이미지 기반 가이더를 perceptual loss 지각 손실을 통해 구현했다 (섹션 D.6 참조).

Bicubic degration 바이큐빅 열화 과정은 이러한 전처리 방식을 따르지 않는 이미지에 잘 일반화되지 않기 때문에, 더 다양한 열화를 사용하여 일반 모델인 LDM-BSR도 훈련하였으며 결과는 섹션 D.6.1에 나와 있다.

4.5. Inpainting with Latent Diffusion

인페인팅은 이미지의 마스킹된 영역을 새로운 내용으로 채우는 작업으로, 이미지의 일부가 손상되었거나 이미지 내의 기존의 원치 않는 내용을 대체하기 위해 수행된다. 저자들은 조건부 이미지 생성을 위한 일반적인 접근 방식이, 인페인팅을 위한 더 전문화된 최신 접근 방식과 어떻게 비교되는지 평가했다. Fast Fourier Convolutions에 의존하는 전문화된 아키텍처를 도입한 최신 인페인팅 모델인 LaMa의 프로토콜을 따라서 평가를 수행했다. Places에서의 정확한 훈련 및 평가 프로토콜은 섹션 E.2.2에 설명이 나와 있다.

먼저 첫 번째 단계에 대한 다양한 설계 선택의 영향을 분석했다. 특히, LDM-1 (즉, 픽셀 기반 조건부 DM)과 LDM-4의 인페인팅 효율성을 KL 및 VQ 정규화 모두에 대해 비교했으며, 첫 번째 단계에 어텐션이 없는 VQLDM-4도 비교했다 (위 Table 8 참조). 후자는 고해상도에서 디코딩 시 GPU 메모리를 줄여줍니다. 비교 가능성을 위해 모든 모델의 파라미터 수는 고정했다. 아래 Table 6은 256 x 256 및 512 x 512 해상도에서의 훈련 및 샘플링 처리량, 에포크당 총 훈련 시간 (시간 단위), 그리고 6 에포크 후 validation split 검증 분할에서의 FID 점수를 보고한다. 전반적으로, 픽셀 기반 및 잠재 기반 확산 모델 간에 최소 2.7배의 속도 향상을 관찰했으며, FID 점수는 최소 1.6배 향상되었다.

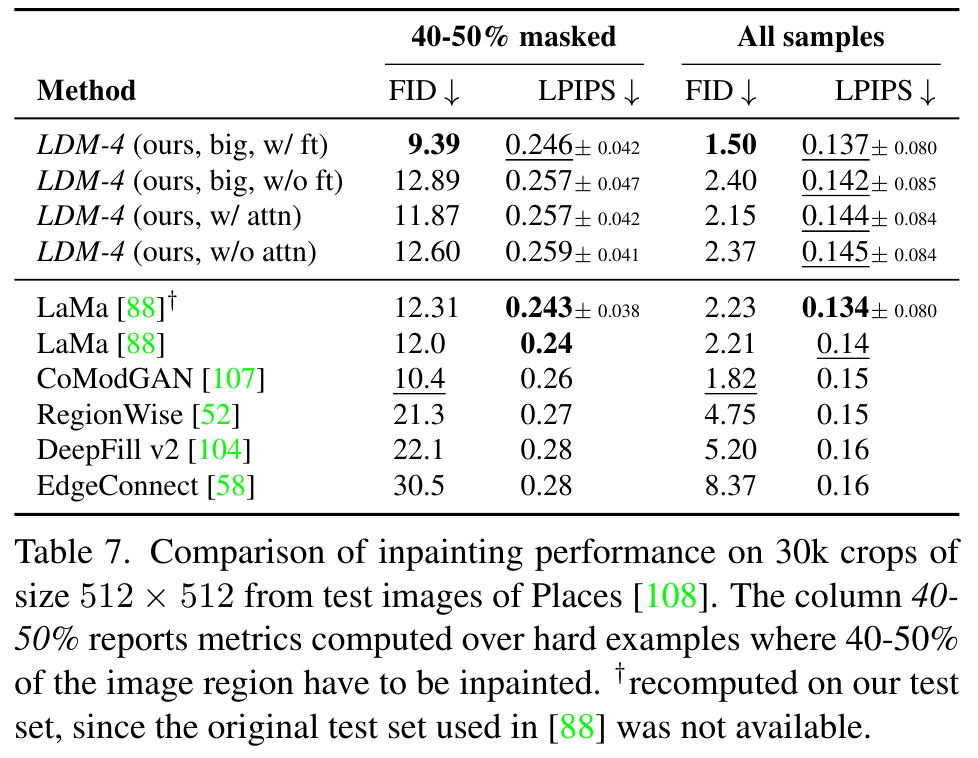

아래 Table 7에서 다른 인페인팅 접근 방식과의 비교는 어텐션을 사용하는 본 모델이 LaMa 모델보다 FID로 측정된 전반적인 이미지 품질을 향상시킴을 보여준다. 마스킹되지 않은 이미지와 저자들의 샘플 간의 LPIPS는 LaMa보다 약간 높다. 이는 LaMa 모델이 단일 결과만을 생성하여 평균적인 이미지를 더 많이 복구하는 경향이 있는 반면, LDM이 생성하는 다양한 결과 (아래 Figure 21 참조) 때문이라고 생각한다. 추가적으로 사용자 연구 (위 Table 4)에서 인간 피험자들은 LaMa의 결과보다 우리의 결과를 선호했다.

이 초기 결과를 바탕으로, 어텐션이 없는 VQ의 정규화된 첫 번째 단계의 잠재 공간에 더 큰 확산 모델 (big in Table 7)을 훈련했다. ADM를 따라, 이 확산 모델의 UNet은 특징 계층의 세 단계에 어텐션 레이어를 사용하고, 업샘플링 및 다운샘플링을 위해 BigGAN의 residual blocks를 사용하며, 215M이 아닌 387M 파라미터를 가진다. 훈련 후에, 256 x 256 및 512 x 512 해상도에서 생성된 샘플의 품질에 불일치가 있음을 발견했는데 이는 추가 어텐션 모듈에 의해 발생한다고 추정한다. 그러나 512 x 512 해상도에서 반 에포크 동안 모델을 fine-tuning하면 모델이 new feature statistics 새로운 특징 통계에 적응하게 되어 이미지 인페인팅에서 새로운 최신 FID 기록을 세웠습니다 (big, w/o attn, w/ ft in 위 Table 7와 아래 Figure 11 참조).

예전에 공부했던 각종 GAN들과 아예 다른 느낌이라 약간 낯설었다.

References:

https://rahites.tistory.com/289

https://velog.io/@qtly_u/paper-Stable-diffusion

'Computer Vision > Generative Models' 카테고리의 다른 글

| Diffusion Model 기본 내용 정리 (0) | 2025.07.02 |

|---|---|

| VAE 정리 (1) | 2025.07.02 |

| Introduction to Generative Models (0) | 2024.02.26 |