Flamingo (2022) 논문 리뷰

Flamingo 모델의 논문 이름은 Flamingo: a Visual Language Model for Few-Shot Learning다. (링크) 저자는 Jean-Baptiste Alayrac, Jeff Donahue, Pauline Luc, Antoine Miech, Iain Barr, Yana Hasson, Karel Lenc, Arthur Mensch, Katie Millican, Malcolm Reynolds, Roman Ring, Eliza Rutherford, Serkan Cabi, Tengda Han, Zhitao Gong, Sina Samangooei, Marianne Monteiro, Jacob Menick, Sebastian Borgeaud, Andrew Brock, Aida Nema..

2025. 5. 5.

Flamingo (2022) 논문 리뷰

Flamingo 모델의 논문 이름은 Flamingo: a Visual Language Model for Few-Shot Learning다. (링크) 저자는 Jean-Baptiste Alayrac, Jeff Donahue, Pauline Luc, Antoine Miech, Iain Barr, Yana Hasson, Karel Lenc, Arthur Mensch, Katie Millican, Malcolm Reynolds, Roman Ring, Eliza Rutherford, Serkan Cabi, Tengda Han, Zhitao Gong, Sina Samangooei, Marianne Monteiro, Jacob Menick, Sebastian Borgeaud, Andrew Brock, Aida Nema..

2025. 5. 5.

Donut (2022) 논문 리뷰

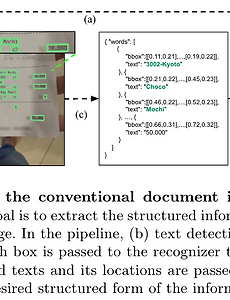

Donut 논문의 제목은 OCR-free Document Understanding Transformer다. (링크) 저자는 Geewook Kim, Teakgyu Hong, Moonbin Yim, Jeongyeon Nam, Jinyoung Park, Jinyeong Yim, Wonseok Hwang, Sangdoo Yun, Dongyoon Han, Seunghyun Park다. Abstract현재의 Visual Document Understanding (VDU) 방법들은 OCR 엔진으로 텍스트를 읽어온 다음 그 결과를 이해하는 태스크에 집중하고 있다. OCR 기반 접근법은 좋은 성과를 보장하지만 다음의 문제점이 있다. 1) OCR를 사용하면 계산량이 많이 필요하며, 2) 문서의 종류나 언어에 따라서 OC..

2025. 5. 3.

Donut (2022) 논문 리뷰

Donut 논문의 제목은 OCR-free Document Understanding Transformer다. (링크) 저자는 Geewook Kim, Teakgyu Hong, Moonbin Yim, Jeongyeon Nam, Jinyoung Park, Jinyeong Yim, Wonseok Hwang, Sangdoo Yun, Dongyoon Han, Seunghyun Park다. Abstract현재의 Visual Document Understanding (VDU) 방법들은 OCR 엔진으로 텍스트를 읽어온 다음 그 결과를 이해하는 태스크에 집중하고 있다. OCR 기반 접근법은 좋은 성과를 보장하지만 다음의 문제점이 있다. 1) OCR를 사용하면 계산량이 많이 필요하며, 2) 문서의 종류나 언어에 따라서 OC..

2025. 5. 3.