BLIP-2의 논문 제목은 BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Models다. (링크)

저자는 Junnan Li, Dongxu Li, Silvio Savarese, Steven Hoi다.

기존의 BLIP은 ViT와 BERT, 이미지와 텍스트 모델을 둘 다 학습시켰다면 BLIP-2에서는 이미지와 텍스트를 연결하는 Q-Former만을 학습한다는 점에서 차이점이 있다.

Abstract

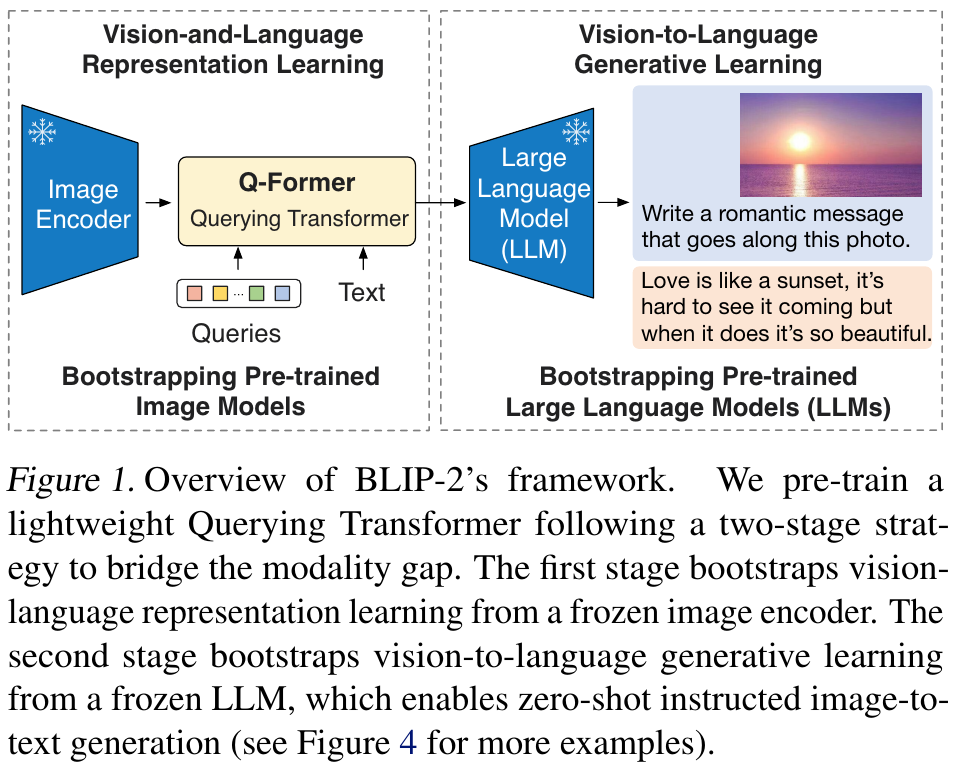

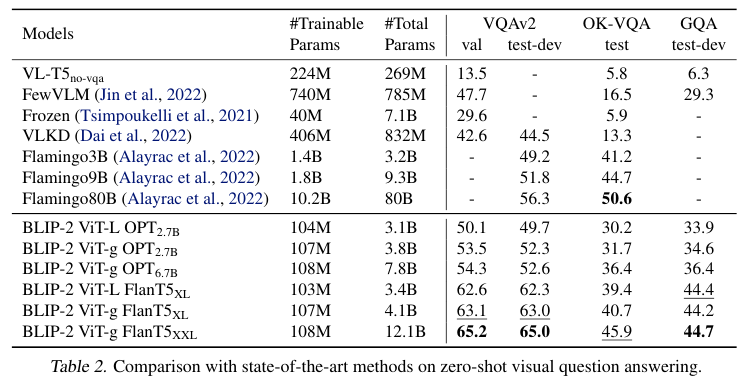

본 논문에서는 pre-trained frozen 이미지 인코더와 frozen LLM을 사용하여 vision-language 시각-언어 사전 학습을 부트스트랩하는 일반적이고 효율적인 사전 학습 전략인 BLIP-2를 제안한다. BLIP-2는 두 단계로 사전 학습되는 lightweight Querying Transformer 경량 쿼리 트랜스포머를 사용하여 모달리티 사이의 갭을 메운다. 첫 번째 단계는 frozen 이미지 인코더에서 시각-언어 representation learning 표현 학습을 부트스트랩한다다. 두 번째 단계는 frozen 언어 모델에서 시각-언어 generative learning생성 학습을 부트스트랩합니다. BLIP-2는 기존 방법보다 파라미터 수가 훨씬 적음에도 불구하고 다양한 시각-언어 작업에서 SOTA 성능을 달성했다. 본 논문의 모델은 zero-shot VQAv2에서 Flamingo 80B보다 8.7% 더 우수한 성능을 보이며, 학습 가능한 매개변수는 54배 더 적다. 또한 natural language instruction 자연어 지시를 따를 수 있는 제로샷 이미지-텍스트 생성 모델의 기능을 보여준다.

아래 Figure 1은 BLIP-2의 대략적인 구조를 보여준다.

3. Method

BLIP-2에서는 모달리티 갭을 메우기 위해서 두 단계의 사전 학습된 Querying Transformer (Q-Former) 구조를 제안한다.

(1) frozen 이미지 인코더와 함께 시각-언어 표현 학습 단계

(2) frozen LLM과 시각에서 언어로 생성하는 학습

3.1. Model Architecture

Q-Former는 입력 이미지의 해상도와 무관하게 고정된 크기의 output features를 추출한다.

Q-Former는 공유된 동일한 self-attention 레이어를 갖는 두 개의 서브 모듈로 구성된다.

(1) 시각적 특징 추출을 위해 frozen 이미지 인코더와 상호작용하는 이미지 트랜스포머

(2) 텍스트 인코더와 텍스트 디코더 역할을 모두 수행할 수 있는 텍스트 트랜스포머

본 연구에서는 이미지 트랜스포머의 입력으로 사전에 설정된 개수의 학습 가능한 쿼리 임베딩을 생성한다.

쿼리는 self-attention 레이어를 통해 서로 상호작용하고, 트랜스포머 블록 마다 삽입되는 cross attention 레이어들 통해 frozen 이미지 피쳐와 상호작용한다. 또한, 쿼리는 동일한 self-attention 레이어를 통해 텍스트와도 상호작용할 수 있다.

사전 학습 작업에 따라, 쿼리-텍스트 상호작용을 제어하기 위해 다양한 self-attention mask를 적용한다다. QFormer는 BERT 기반의 사전 학습된 가중치로 초기화하는 반면, cross attention 레이어는 무작위로 초기화한다. Q-Former는 총 18,800만 개의 매개변수를 가진다. 쿼리는 모델의 파라미터로 간주한다.

실험에서는 각 쿼리의 차원이 768 (Q-Former의 hiddend dimension과 동일)인 32개의 쿼리를 사용한다. Output query represenation 출력 쿼리 표현은 Z로 나타낸다. Z의 크기(32 × 768)는 frozen 이미지 특징의 크기(예: ViT-L/14의 경우 257 × 1024)보다 훨씬 작다. 이 bottleneck architecture 병목 아키텍처는 사전 학습의 objectives 목표 함수와 함께 쿼리가 텍스트와 가장 관련성이 높은 시각 정보를 추출하도록 강제한다.

3.2. Bootstrap Vision-Language Representation Learning from a Frozen Image Encoder

표현 학습 단계에서는 Q-Former를 고정 이미지 인코더에 연결하고 이미지-텍스트 쌍을 사용하여 사전 학습을 수행한다.

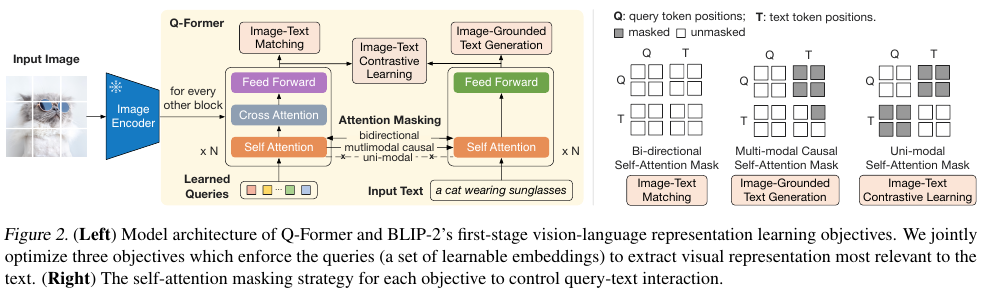

BLIP에서 영감을 받아, 동일한 입력 형식과 모델 매개변수를 공유하는 세 가지 사전 학습 목표를 동시에 최적화한다. 각 목표는 질의와 텍스트 간의 상호작용을 제어하기 위해 Figure 2에 그려진 서로 다른 어텐션 마스킹 전략을 사용한다.

Image-Text Constrasive Learning (ITC)

이미지 표현과 텍스트 표현을 정렬하여 mutual information이 최대가 되도록 학습한다. 이미지-텍스트의 postivie parirs와 negative paris에 대해서 contrasting함으로써 달성한다. 이미지 트랜스포머의 Output query represenation Z를 텍스트 트랜스포머의 텍스트 표현 t와 align 정렬한다. 여기서 t는 [CLS] 토큰의 출력 임베딩이다. Z는 여러 출력 임베딩(각 쿼리에서 하나씩)을 포함하므로, 먼저 각 쿼리 출력과 t 사이의 pairwise 쌍별 유사도를 계산한 다음, 가장 높은 값을 이미지-텍스트 유사도로 선택한다.

Information leak 정보 유출을 방지하기 위해 쿼리와 텍스트가 서로를 인식하지 못하도록 하는 unimodal self-attention mask를 사용한다. Frozen 이미지 인코더를 사용함으로써 multimodal 방식보다 GPU당 더 많은 샘플을 피팅할 수 있다. 따라서 BLIP에서 사용한 momentum queue 모멘텀 큐 대신 in-batch negatives을 사용한다.

Image-grounded Text Generation (ITG)

입력 이미지가 조건으로 주어졌을 때 Q-Former가 텍스트를 생성하도록 학습한다. Q-Former의 아키텍처는 frozen 이미지 인코더와 텍스트 토큰 간의 직접적인 상호작용을 허용하지 않으므로, 텍스트 생성에 필요한 정보는 먼저 쿼리를 통해 추출된 후, 셀프 어텐션 레이어을 통해 텍스트 토큰으로 전달되어야 한다. 따라서 쿼리는 텍스트에 대한 모든 정보를 포착하는 시각적 특징을 추출해야 한다. 본 논문에서는 UniLM 에서 사용된 것과 유사한 multimodal causal self-attention mask를 사용하여 쿼리-텍스트 상호작용을 제어한다. 쿼리는 서로에게 어텐션을 할 수 있지만 텍스트 토큰에는 어텐션을 할 수 없다. 각 텍스트 토큰은 모든 쿼리와 이전 텍스트 토큰에 어텐션을 할 수 있다. 또한, 디코딩 작업을 알리는 첫 번째 텍스트 토큰으로 [CLS] 토큰을 새로운 [DEC] 토큰으로 대체한다.

Image-Text Matching (ITM)

이미지와 텍스트 표현 간의 세밀한 alignment 정렬을 학습하는 것이 목표다. 이는 모델이 이미지-텍스트 쌍이 positive (matched 일치)인지 negative (unmatched)인지 예측하도록 하는 binary classification 작업이다. 모든 쿼리와 텍스트가 서로에게 attention을 취할 수 있는 bi-directional self-attention mask크를 사용합니다.

따라서 output query embeddings 출력 질의 임베딩 Z는 multimodal 정보를 포착한다. 각각의 출력 질의 임베딩 Z를 two-class classifier에 입력하여 logit을 구하고 이를 모든 쿼리의 logits의 평균을 output matching score 출력 일치 점수로 사용한다. Hard negative mining 전략을 선택해서 informative 정보가 있는 negative paris를 생성한다.

3.3. Bootstrap Vision-to-Language Generative Learning from a Frozen LLM

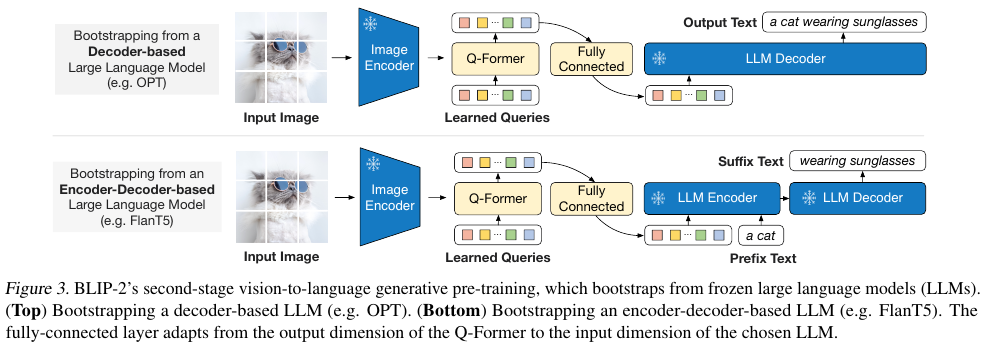

Generative pre-training stage 생성 사전 학습 단계에서는 frozen 이미지 인코더가 연결된 Q-Former를 frozen LLM에 연결하여 LLM의 생성 언어 기능을 활용한다.

위 Figure 3에서 볼 수 있듯이, Fullcy-connected (FC) 완전 연결 레이어를 사용하여 출력 쿼리 임베딩 Z를 LLM의 텍스트 임베딩과 동일한 차원으로 linear projection 선형 투영한다. 투영된 쿼리 임베딩은 입력 텍스트 임베딩 앞에 추가된다. 이 임베딩들은 Q-Former가 추출한 시각적 표현을 기반으로 LLM을 조건화하는 soft visual prompts 소프트 시각적 프롬프트 역할을 하게 된다. Q-Former는 language-informative visual representation 언어 정보적인 시각적 표현을 추출하도록 사전 학습되었으므로, LLM에 가장 유용한 정보를 제공하는 동시에 관련 없는 시각적 정보는 제거하는 정보 병목 현상 역할을 효과적으로 수행한다. 이를 통해 LLM이 시각-언어 정렬을 학습해야 하는 부담을 줄여 catastrophic forgetting 치명적인 망각 문제를 완화할 수 있다.

디코더 기반 LLM과 인코더-디코더 기반 LLM, 두 가지 유형의 LLM을 실험했다. 디코더 기반 LLM의 경우, Language modeling loss 언어 모델링 손실을 사전 학습하여 고정된 LLM이 Q-Former의 시각적 표현을 기반으로 텍스트를 생성하도록 한다. 인코더-디코더 기반 LLM의 경우, Prefix language modeling loss를 사전 학습하여 텍스트를 두 부분으로 분할한다. Prefix text는 시각적 표현과 연결되어 LLM 인코더의 입력으로 사용된다. Suffix text는 LLM 디코더의 생성 대상으로 사용된다.

3.4. Model Pre-training

Pre-training data.

BLIP과 동일한 사전 학습 데이터셋을 사용했으며, 총 129 M개의의 이미지를 사용했다. 여기에는 COCO, Visual Genome, CC3M, CC12M, SBU 및 LAION400M 데이터셋의 1억 1,500만 개의 이미지를 포함한다. 웹 이미지에 대한 합성 캡션을 생성하기 위해 CapFilt 방법을 채택했다. 구체적으로, BLIP 대용량 캡션 모델을 사용하여 10개의 캡션을 생성하고, CLIP ViT-L/14 모델에서 생성된 이미지-텍스트 유사도를 기반으로 합성 캡션과 원본 웹 캡션의 순위를 매겼다. 이미지당 상위 두 개의 캡션을 학습 데이터로 유지하고, 각 사전 학습 단계에서 하나씩 무작위로 샘플링한다.

Pre-trained image encoder and LLM

두 가지 SOTA 사전 학습 비전 트랜스포머 모델을 탐색했다. 바로 (1) CLIP의 ViT-L/14와 (2) EVA-CLIP의 ViT-g/14 다. ViT의 마지막 계층을 제거하고 두 번째 마지막 계층의 출력 특징을 사용하여 성능이 약간 향상되었다.

Frozen LM의 경우 디코더 기반 LLM의 경우 unsupervised trained 비지도 학습된 OPT model family 모델 군을, 인코더-디코더 기반 LLM의 경우 명령어 학습된 FlanT5 모델군을 탐색했다.

Pre-training settings

1단계에서는 250k 스텝, 2단계에서는 80k 스텝의 사전 학습을 수행한다.

1단계에서는 ViT-L/ViT-g에 2320/1680의 배치 크기를 사용하고, 2단계에서는 OPT/FlanT5에 1920/1520의 배치 크기를 사용한다. 사전 학습 과정에서 동결된 ViT와 LLM의 매개변수를 FP16으로 변환한다. 예외적으로 FlanT5에서는 BFloat16을 사용한다. 32비트 모델을 사용했을 때와 비교했을 때 성능 저하가 발생하지 않았다. Frozen 동결된 모델을 사용했기 때문에 사전 학습은 기존의 대규모 VLP 방식보다 연산 효율이 높다. 예를 들어, 단일 16-A100(40G) 머신을 사용하여 ViT-g와 FlanT5-XXL을 적용한 가장 큰 모델은 1단계에서 6일 미만, 2단계에서 3일 미만이 소요된다.

모든 모델에 동일한 사전 학습 하이퍼파라미터 세트를 사용한다. $\beta_1$ = 0.9, $\beta_2$ = 0.98, 그리고 weight decay는 0.05이며, AdamW옵티마이저를 사용한다. 최대 학습률이 1e-4이고 linear warmup 선형 워밍업이 2k 단계인 cosine learning rate decay를 사용합니다. 두 번째 단계의 최소 학습률은 5e-5 다. 이때, 무작위로 크기를 조정한 자르기와 수평 뒤집기를 통해 증강된 224x224 크기의 이미지를 사용한다.

4. Experiments

Zero-shot Vision Tasks

위 Figure 4는 instructed zero-shot image-to-text 생성의 예시다.

Table 1에서는 BLIP-2와 BLIP, BEIT-3, SimVLM, Flamingo와의 비교 결과를 보여준다.

Table 2에서는 BLIP-2 중에서 OPT와 FlanT5의 비교 결과도 볼 수 있는데 전반적으로 OPT 보다 FlanT5가 더 좋은 결과임을 보여준다.

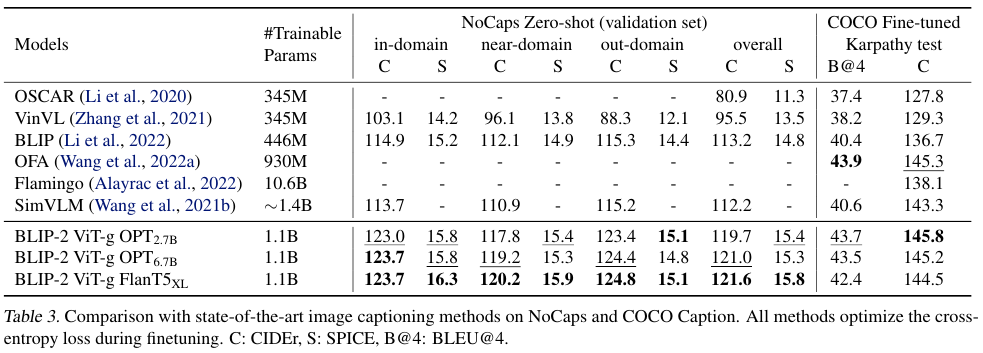

Captioning

Table 3에서는 캡션 생성 실험 결과를 보여준다.

아래는 Fine Tuning한 결과들이다.

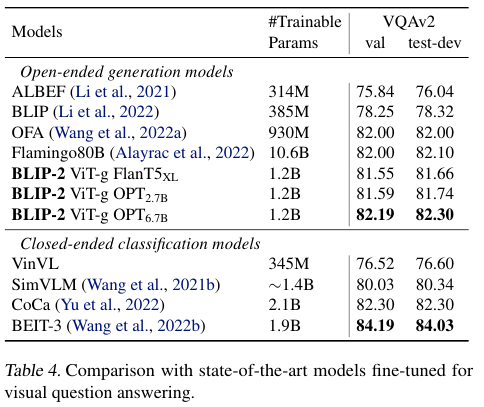

VQA

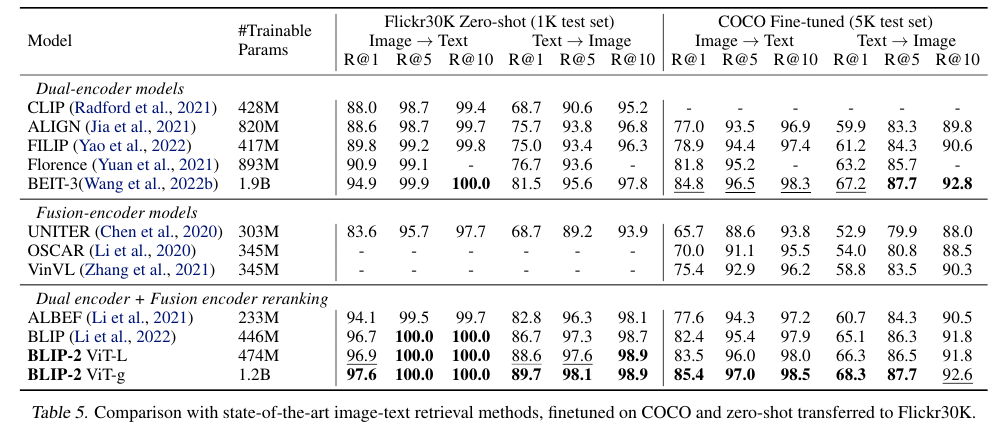

Zero-shot Image-text retrieval

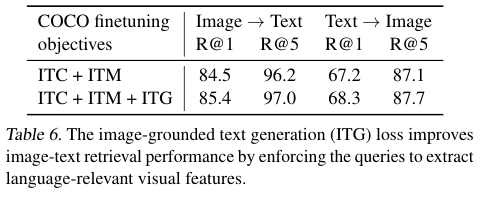

ITG Ablation Study

ITG를 적용함으로써 성능이 약간 향상되었음을 Table 6을 통해 확인할 수 있다.

References:

https://chanmuzi.tistory.com/372

https://letter-night.tistory.com/426

'Multimodal' 카테고리의 다른 글

| Flamingo (2022) 논문 리뷰 (0) | 2025.05.05 |

|---|---|

| Donut (2022) 논문 리뷰 (0) | 2025.05.03 |

| DALL-E (2021) 논문 리뷰 (1) | 2025.05.03 |

| LLaVA (2023) 논문 리뷰 (0) | 2025.04.26 |

| BLIP (2022) 논문 리뷰 (0) | 2025.04.26 |