금융이나 의료와 같은 특수한 도메인에 대한 LLM을 리서치했다.

금융의 경우 BloombergGPT나 FinGPT가 있지만 이외의 영역은 Meditron 같은 모델 외에 어떤게 있나 찾아보았다.

1. Arya.ai의 What is a Domain-Specific LLM? Examples and Benefits 글: 링크

2. Self-specialization에 관한 트위터 글: 링크

3. Super Annotate의 Domain-Specific LLMs: How to Make AI Useful for Your Business 글: 링크

4. ICLR2024에 실린 Adapting LLMs to Domains via Continual Pre-Training의 Huggingface: 링크

의료, 금융, 법의 영역을 다룬다. 논문: 링크

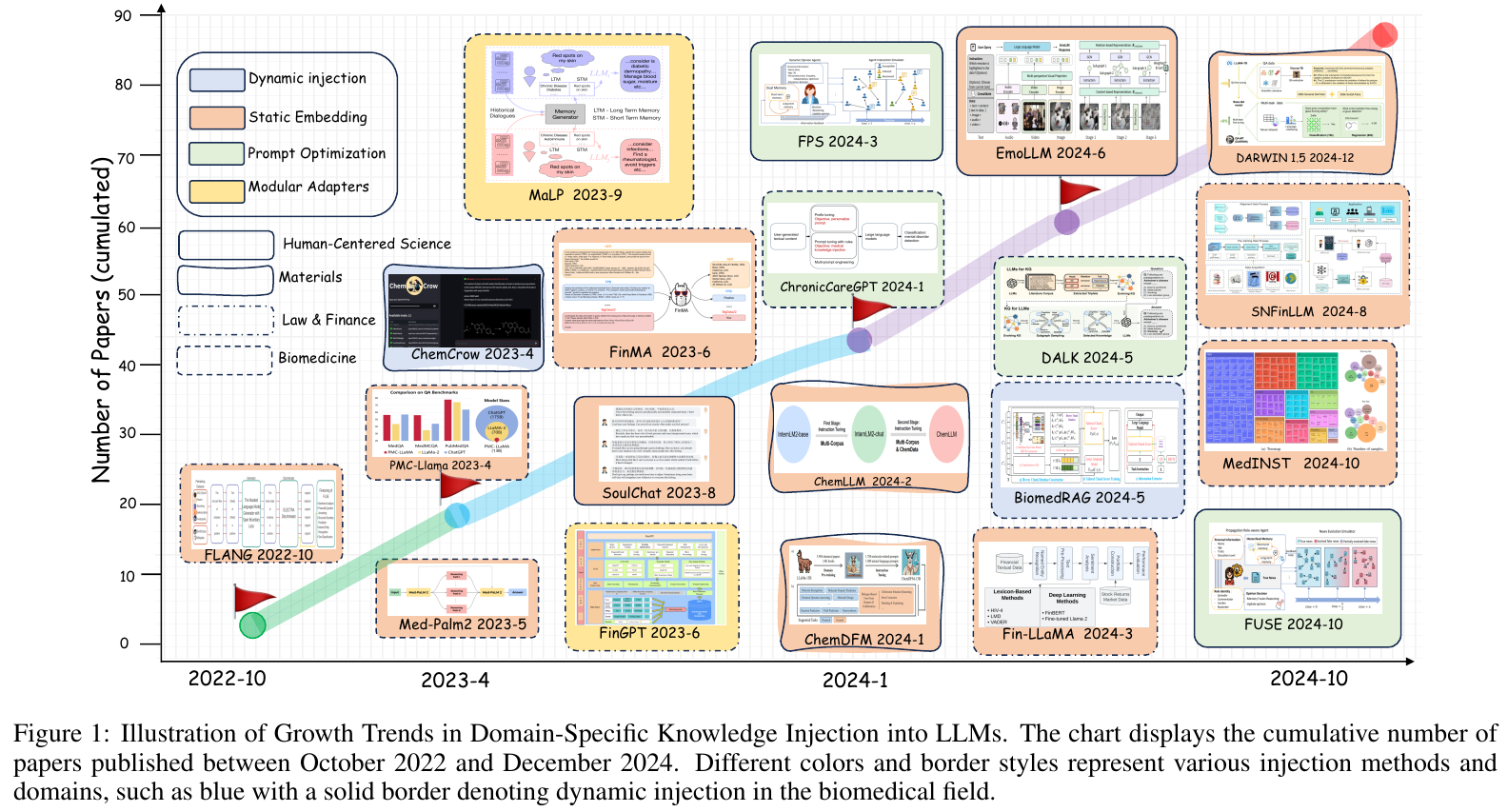

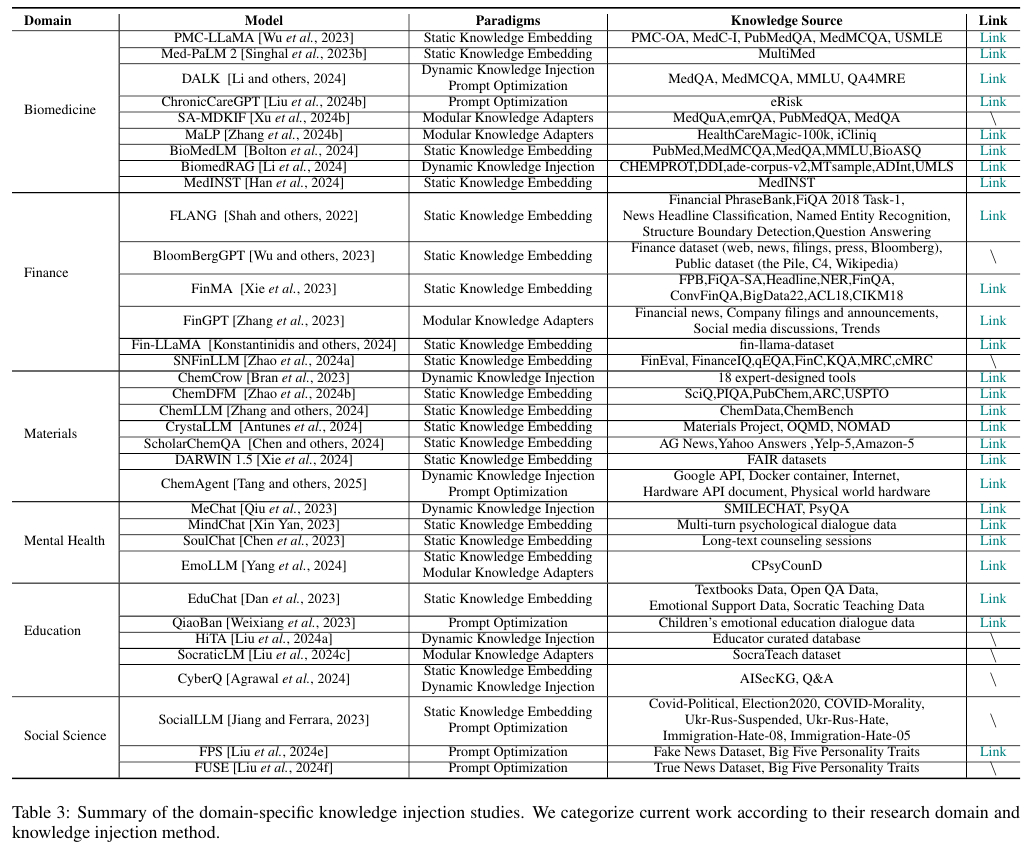

5. Injecting Domain-Specific Knowledge into Large Language Models: A Comprehensive Survey 논문: 링크

Gihub: 링크

6. Pre-train 데이터를 포함한 LLM 데이터에 대한 논문을 소개한 파이토치 코리아의 글인 대규모 언어 모델(LLM)을 위한 데이터셋들에 대한 종합적인 연구: 링크

Injecting Domain-Specific Knowledge into Large Language Models: A Comprehensive Survey

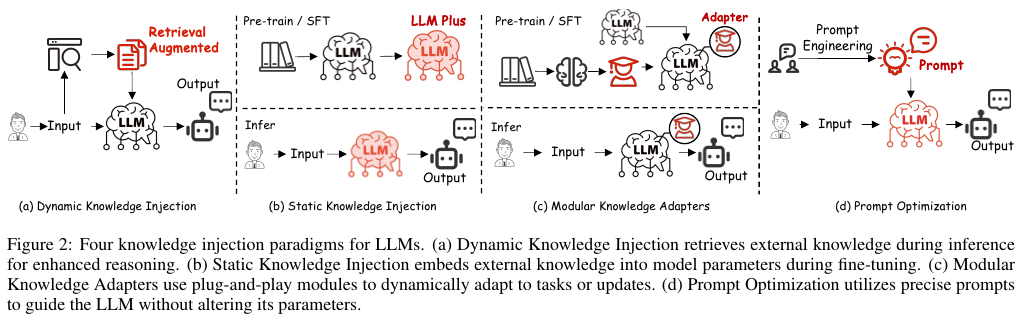

위에 나온 Static Knowledge Embedding, Dynamic Knowledge Injection, Adapters, Prompt Optimization을 설명하면 다음과 같다.

- Static Knowledge Embedding은 모델 자체가 해당 지식을 가지게 만드는 Training이나 Fine tuning을 의미한다.

- Dynamic Knowledge Injection은 추론 과정에서 외부 지식을 검색하고 통합하는 RAG와 같은 방법이다.

- Adapters는 LoRA와 같이 기존의 모델은 그대로 두면서 외부 지식을 저장할 별도의 모듈을 말한다.

- Prompt Optimization은 말 그대로 프롬프트를 적절하게 사용하는걸 의미한다.

BloomberGPT와 Meditron은 Wikipedia와 같은 웹 데이터와 금융 / 의료 데이터를 혼합하여 pre-train부터 한 모델이고, FinGPT는 LoRA로 파인 튜닝한 모델이고 FinLoRA는 QLoRA로 파인튜닝한 모델이다.

'NLP > LLM' 카테고리의 다른 글

| LLM의 컨텍스트 윈도우와 관련된 글 (1) | 2025.09.01 |

|---|---|

| Mamba (2023) 논문 리뷰 (2) | 2025.08.26 |

| MUVERA와 Mercury 리서치 (1) | 2025.07.15 |

| Mixtral (2024) 논문 리뷰 (0) | 2025.06.24 |

| Codex (2021) 논문 리뷰 (1) | 2025.06.24 |