RoBERTa: A Robustly Optimized BERT Pretraining Approach 논문은 BERT의 variant다. (링크)

해당 논문의 저자는 Yinhan Liu, Myle Ott, Naman Goyal, Jingfei Du, Mandar Joshi, Danqi Chen, Omer Levy, Mike Lewis, Luke Zettlemoyer, Veselin Stoyanov다.

Abstract

추가적인 하이퍼파라미터와 트레이닝 데이터 사이즈 등을 이용해서 BERT의 성능을 향상시켰다.

GLUE, RACE, SQuAD 데이터에 대해서 SOTA 성능을 달성했다.

Training Procedure Analysis

기본적으로 BERT의 기본적인 configuration을 그대로 사용한다.

L = 12, H = 768, A = 12, 110M params.

4.1. Static vs Dynaminc Masking

기존 BERT에서는 masking을 한 번만 수행하고 전체 트레이닝 epochs와 steps에 대해서 동일하게 가져간다.

이를 static 방법이라고 한다.

RoBERTa의 저자들은 dynamic masking을 제안한다. 모델에 sequence를 넣을 때 마다 masking을 수행한다.

Dynamic이 약간 더 성능이 좋아 보인다.

4.2. Model Input Format and Next Sentence Prediction

원본 BERT의 pre-training 과정에서 모델은 두 가지 종류의 문서를 본다.

첫 번째는 두 문서 사이의 선후 관계가 존재하고 두 번째는 서로 선후 관계가 없다.

아래의 4가지 방법 모두 max sequence of tokens는 512로 동일하다.

본 논문에서는 이를 보다 깊게 분석해본다.

SEGMENT-PAIR+NSP

원본 BERT와 같다.

SENTENCE-PAIR+NSP

하나의 문서에서 나오거나 다른 문서에서 나오더라도 순서상 근접한 경우의 문장들을 뽑는다.

FULL- SENTENCES

하나 이상의 문서에서 문장들을 뽑는다.

DOC- SENTENCES

여러가지 문서가 아니라 문서 내에서만 뽑는다.

NSP를 사용하지 않고 최대한 많은 문장 (tokens)를 학습하는게 더 성능이 좋음을 확인할 수 있다.

특히 DOC- SENTENCES가 제일 좋은 성능을 보여준다.

4.3. Training with large batches

Batch size를 2K로, lr을 줄인게 가장 좋은 성능을 보여준다.

4.4. Text Encoding

원본 BERT에서는 BPE를 character-level로 사용했다. 저자들은 byte-level BPE와 비교했는데 바이트 레벨이 약간 더 성능이 안 좋았다고 한다. 하지만 바이트 레벨의 universal encoding의 이점이 더 좋다고 생각하기 때문에 바이트 레벨 BPE를 선택했다고 한다.

5. RoBERTa

Robustly optimized BERT approach.

앞서 살펴본 각각의 내용을 합쳐서 BERT Large에 대해서도 살펴본다.

BERT large는 L = 12, H = 1024, A = 16, 355M params다.

BookCorpus와 Wikipedia 데이터를 활용해서 학습했다.

더 많은 데이터를 사용하고, 큰 배치 사이즈를 활용해서 더 많은 steps를 학습할 수록 좋은 성능을 보였다.

GLUE에 대한 파인 튜닝 결과인데 RoBERTa가 XLNet이나 BERT 보다 좋은 성능임을 알 수 있다.

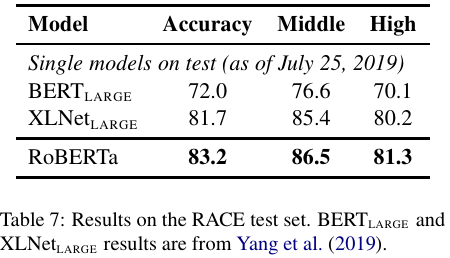

SQuAD와 RACE에서도 RoBERTa SQuAD v1.1의 EM을 제외하고는 가장 좋은 성능을 보여준다.

References:

https://velog.io/@tobigs-nlp/RoBERTa

'NLP' 카테고리의 다른 글

| Instruct learning, fine tuning, and T5 (0) | 2025.01.28 |

|---|---|

| T5 (2019) 논문 리뷰 (0) | 2024.11.08 |

| BART (2019) 논문 리뷰 (0) | 2024.11.04 |

| GPT (2018) 논문 리뷰 (0) | 2024.07.22 |

| BERT (2018) 논문 리뷰 (0) | 2024.06.25 |