GPT2의 논문 이름은 Language Models are Unsupervised Multitask Learners다. (링크)

저자는 Alec Radford, Jeffrey Wu, Rewon Child, David Luan, Dario Amodei, Ilya Sutskever다.

Unsupervised pre-train 이후 fine-tuning이 아닌 pre-train 만으로 충분히 좋은 성능을 낼 수 있는 가능성을 보여준 논문이다.

Abstract

Question answering, machine translation, reading comprehension, 그리고 summarizaiton은 대표적인 supervised learning으로 학습되는 개별적인 태스크들이다. 저자들은 명박한 (explicit) supervison이 없이도 위 태스크들에 대해서 학습이 가능한데, 이는 WebText라고 불리는 수백만의 웹페이지를 통한 학습으로 달성될 수 있다고 주장한다.

CoQA 데이터 셋에 대해서 F1을 55 달성하였으며 이는 3/4에 해당하는 베이스라인 보다 좋은 성능이다.

GPT-2의 가장 큰 모델은 1.5B의 파라미터를 가지며 8개 중 7개의 테스트에 대해서 SOTA를 달성하였으며 이는 모두 Zero-shot이다.

2. Approach

기본적으로 언어 모델의 예측인 next token prediction은 아래와 같은 conditional probability로 표현할 수 있다.

이때 조건부 확률은 p(output | input) 대신 p(output | input, task)와 같은 형식으로 설정한 연구들이 있었다.

다른 예시로는 tasks에 맞게 sequence를 더 세부적으로 조정하는 방법도 제시되었다.

번역의 경우 (translate to french, english text, french text)와 같이,

reading comprehension의 경우 (answer the question, document, question, answer)과 같은 형태다.

보다 자세한 내용은 블로그의 이 두 글 (링크1, 링크2) 을 보면 된다.

하지만 unsupervised objective의 global minimum은 supervised objective의 global minimum을 포함하고,

충분히 많은 양의 데이터를 충분히 큰 모델을 통해서 unsupervised objective를 학습하면 다양한 태스크들에 대해서도 좋은 성능을 낼 수 있다.

2.1. Training Datasets

기존의 웹페이지 데이터인 Common Crawl은 데이터 퀄리티와 관련된 이슈가 있었다.

따라서 WebText라는 새로운 데이터를 제시한다.

사람에 의해서 수집되었으며 Reddit의 outbound links들 중에서 각각이 최소한 3 카르마를 받은 데이터만을 수집했다.

휴리스틱한 지표로 링크가 흥미롭거나, 교육적이거나 재밌다고 간주했다.

Dragnet와 Newspaper content extract를 이용해서 HTML로 부터 텍스트를 수집했다.

De-duplication (데이터 중복 제거)와 휴리스틱한 정제를 거친 데이터는 약 8M의 문서였으며 총 40GB의 텍스트다.

Wikipedia를 제거했는데 이는 다른 데이터 소스에서 찾아볼 수 있기도 하고 테스트 평가 태스크의 학습 데이터와 겹칠 수도 있기 때문이다.

2.2. Input Representation

기본적으로 Byte-level BPE를 사용하였다. 하지만 dog와 같은 단어가 dog. dog! dog? 와 같이 여러 variation가 있게 되고 이는 sub-optimal allocation을 야기하며 vocab slot과 model capacity를 낭비한다고 생각했다. 이를 방지하기 위해서 character 레벨의 카테고리를 고려해서 카테고리가 다르면 서로 merge하지 못하도록 했다.

2.3. Model

기본적으로 GPT와 동일하다.

대신 Layer normalization을 sub-block의 input 자리로 위치를 이동했다.

추가적인 layer normalization을 마지막 self-attention block에 추가했다.

Vocab size는 50,257이고 context size를 512에서 1024로 늘렸으며

batch size는 512를 사용했다.

3. Experiments

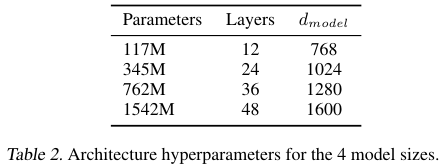

다양한 크기의 모델들이 Table 2에 나와있다.

Table 1에서는 WebText의 트레이닝 데이터의 예시를 보여준다.

가장 큰 1542M (1.5B) 모델이 거의 모든 벤치마크에서 좋은 성능을 달성했음을 확인할 수 있다.

References:

'NLP' 카테고리의 다른 글

| GLU variants (2020) 논문 리뷰 (0) | 2025.04.09 |

|---|---|

| MQA (Multi-Query Attention) (2019) 논문 리뷰 (0) | 2025.04.09 |

| Sentence-BERT (2019) 논문 리뷰 (0) | 2025.04.09 |

| Instruct learning, fine tuning, and T5 (0) | 2025.01.28 |

| T5 (2019) 논문 리뷰 (0) | 2024.11.08 |