Language Model은 크게 Pre-train과 Fine-tuning 단계가 있다.

GPT 3 이후 Pre-trian 단계에서 막대한 양의 데이터를 NTP (Next token prediction)과 In-context Learning (ICL)의 측면에서 학습을 한다.

그동한 읽었던 논문들에서 많이 쓰이는 대용량의 고품질 데이터들을 간단하게 정리하고자 한다.

- Wikipedia

- C4 (Colossal Clean Crawled Corpus)

- The Pile

- Refined Web

- FineWeb

- WebText

- RedPajama

- Book Corpus

Wikipedia

300개가 넘는 언어를 지원하는 데이터다.

C4

구글에서 만든 common crawl에 기반한 100개가 넘는 언어를 지원하는 데이터다.

T5에서는 영어만 사용했지만 여러 언어에 대해 학습한 mT5 모델에서는 다중언어에 대해서 학습을 했다.

이때 사용한 multilingual C4가 mC4다.

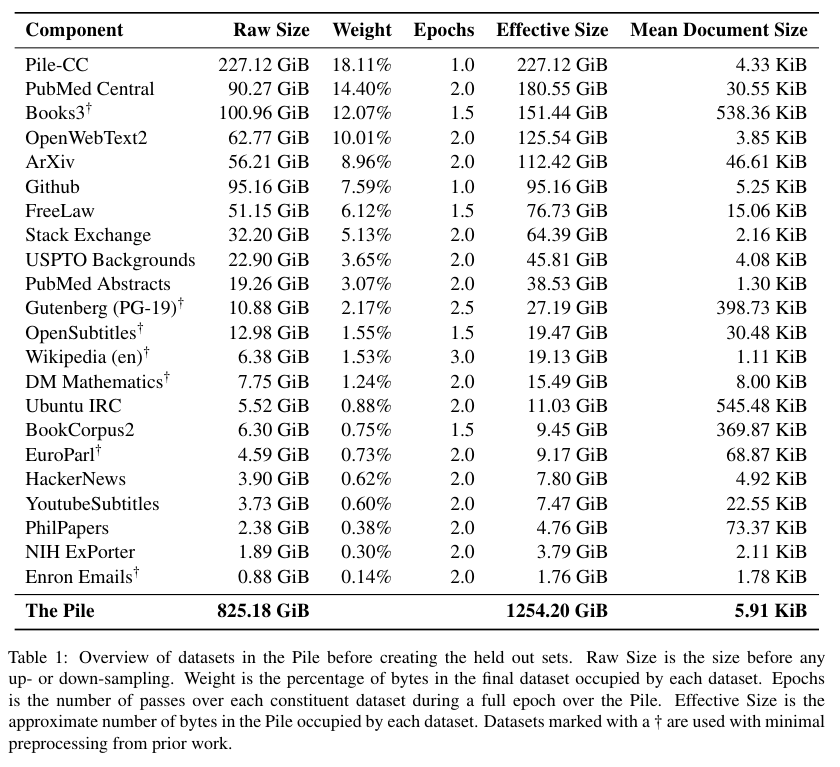

The Pile

EleutherAI에서 만든 800 GB 분량의 영문 언어 데이터다.

총 22개의 더 작은 데이터들로 이루어진 데이터다.

PubMed Central, ArXiv, Github, the FreeLwa Project, Stack Exchange, the US Patent and Trademark Officie, PubMed, Ubuntu IRC, HackerNews, YouTube, PhilPapers, and NIH ExPorter에서 데이터를 얻어왔다. 또한 OpenWebText2와 BookCorpus2를 제안하는데 이는 원본 OpenWebText와 BookCorpur의 확장 버젼이다.

Pile-CC는 2008년 부터 시작된 Common Crawl을 원본으로 정제한 데이터다.

RefinedWeb

- (논문 링크)

- (hugginface link)

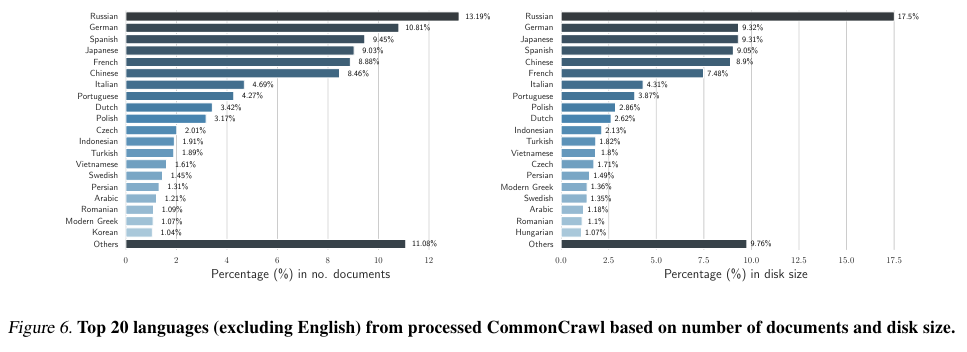

TIIUAE의 Falcon 팀에서 만든 multilingual 다중언어 데이터다.

CommonCrawl의 원본 5 T 토큰에서 600 B 토큰을 추출했다.

영어를 제외하고 러시아어, 독일어, 스페인어, 일본어, 프랑스어, 중국어를 비롯해서 한국어로 포함한 데이터다.

The FineWeb

- (논문 링크)

- (hugginface link)

Huggingface에서 만든 데이터로 Common Crawl의 15 T 토큰으로 부터 정제해서 1.3 T 토큰으로 만든 데이터다.

기본적으로 영어만 포함하고 있다.

RedPajama

- (논문 링크)

- (hugginface link)

영어, 독일어, 프랑스어, 이탈리아어, 스페인어로 구성된 30 T 토큰짜리 데이터다.

Common Crawl, C4, GitHub, Books, ArXiv, Wikipedia, StackExhange의 데이터를 모아서 정제했다.

RedPajam는 v1, v2, SlimPajama 등 다양한 버젼이 존재한다.

슬림 파자마는 MinHashLSH로 레드 파자마의 dedupliacte 중복을 제거한 데이터다.

'NLP > NLP - Data & Eval' 카테고리의 다른 글

| RAGAS (2023) 논문 리뷰 (0) | 2025.04.17 |

|---|---|

| LLM as a Judge (2023) 논문 리뷰 (1) | 2025.04.17 |

| GLUE, SuperGLUE, KLUE, Huggingface LB (0) | 2024.03.04 |