요즘은 LLM의 등장 이후 이런 거대 모델 백본으로 하여 전이 학습 등을 적용한 사례들이 늘어나고 있다.

LLM은 다양한 자연어 태스크를 처리할 수 있도록 학습되는데 이를 위한 벤치마크가 GLUE다.

GLUE와 그 확장 버젼인 SuperGLUE는 영어라서 한국어인 KLUE도 소개한다.

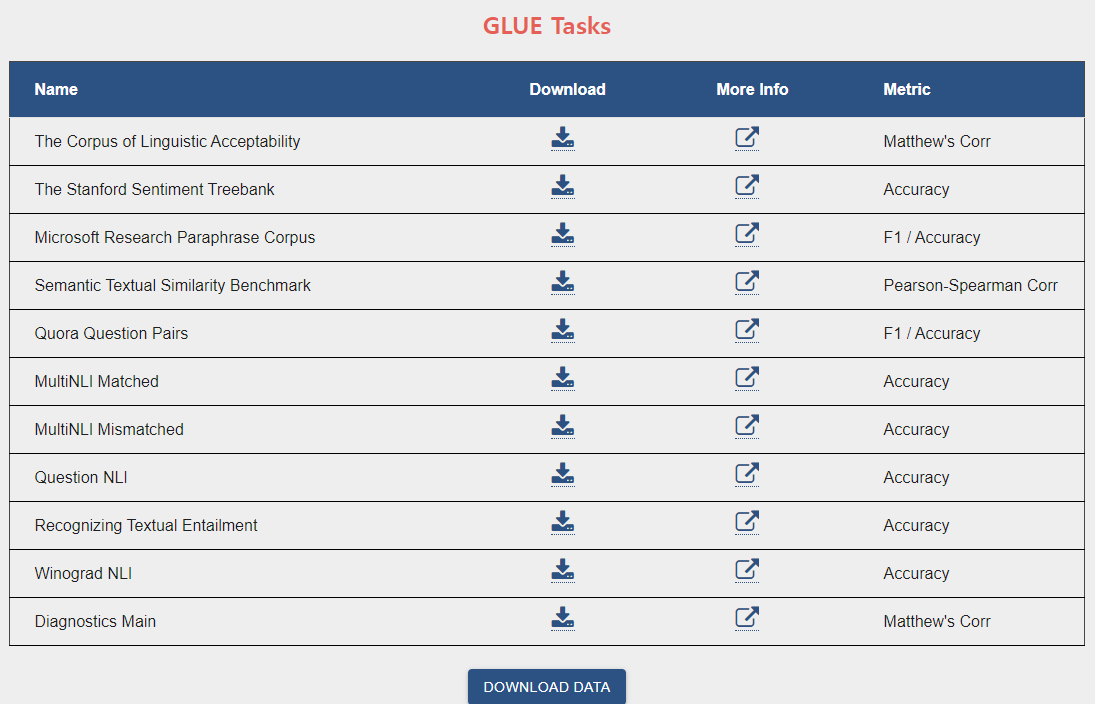

GLUE

GLUE는 General Language Understanding Evaluation의 약자로 다양한 NLU 태스크들을 모아서 인간처럼 여러가지 복잡한 자연어 처리를 수행할 수 있는지를 확인할 수 있는 벤치마크다.

GLUE Tasks는 총 11개다. 각각의 태스크에 맞는 영어 데이터와 부합하는 evaluation metrics가 나와있다.

위에서 부터 차례대로 태스크, 데이터, 메트릭을 살펴보자.

Single-Sentence Tasks

CoLA (The Corpus of Linguistic Acceptability)

언어학적으로 의미가 있는, 문장 구조도 맞고 말도 되는 경우를 파악하는 이진 분류 문제다.

평가 metric은 Matthew's Correlation Coefficient (MCC)로, binary classification에 쓰는 correlation이다.

MCC는 Phi Coefficient와는 달리 Pearson Corr처럼 [-1, 1]의 범위를 갖는다.

The Stanford Sentiment Treebank v2 (STT-2)

영화 리뷰를 긍정, 부정으로 분류하는 감성 분류 태스크다. Positive words와 negative words를 sum up해서 평가한다.

평가 metric은 accuracy다.

Similarity and Paraphrasing Tasks

Miscrosoft Research Phrase Corpus (MRPC)

설명을 보면 paraphrase/semantic equivalence relationship을 측정한다고 하는데,

의미적으로 유사한 5800 pairs의 문장들을 이용해 분류하는 문제다.

평가 metric은 F1 score와 accuracy다.

Semantic Textual Similarity Benchmark (STS-B)

데이터의 성격이 위의 MRPC와 비슷하며, 유사도를 1에서 5까지 라벨링한 점이 차이점이다.

문장은 텍스트, 이미지 캡셔닝, 뉴스헤드 라인, 유저 포럼 데이터 등 여러가지를 모았다고 한다.

평가 metric은 Pearson Correlation과 Spearman Correlation이라고 한다.

Pearson Corr는 우리가 아는 숫자 데이터에 사용하는 코릴레이션으로 -1과 1 사이의 값을 갖는다.

Spearman은 ordinal data에 사용하는 지표로 이 역시 -1과 1 사이의 값을 갖는다.

Quora Question Pairs dataset (QQP)

해외의 네이버 지식인인 Quora 사이트의 질문 답변 쌍을 모은, QA 부문의 데이터다.

평가 metric은 F1 score와 accuracy다.

Natural Language Inference tasks

Multi-Genre Natural Language Inference Corpus (MNLI)

Multi NLI Matched와 Mismatched는 문장 쌍에 대한 언어적 함의 (textual entailment)를 분류하는 문제다.

전제(premise)와 가설(hypothesis)를 entailment, contradiction, neutral을 분류한다.

자세한 내용은 https://ratsgo.github.io/nlpbook/docs/pair_cls/overview/을 참고하면 좋다.

평가 metric은 accuracy다.

Question-Answering NLI (QNLI)

Stanford Question Answering Dataset v1.1 (SQuAD)에서 부터 유래한 데이터셋이라고 한다.

이름에서처럼 알 수 있듯이 QA pairs다. 단순히 어휘가 겹치는게 아니라 의미적으로 유사한 쌍을 찾도록 유도하는 데이터다.

평가 metric은 accuracy다.

Recognizing Textual Entailment (RTE)

MNLI와 비슷하지만, neutral과 contradiction을 not-entailment로 만들어서 이진 분류화했다고 한다.

평가 metric은 accuracy다.

Winograd NLI (WNLI)

대명사가 가리키는 대상을 리스트에서 고르는 문제다.

평가 metric은 accuracy다.

Diagnostics Main

GLUE의 NLI 데이터로 metric은 MCC다.

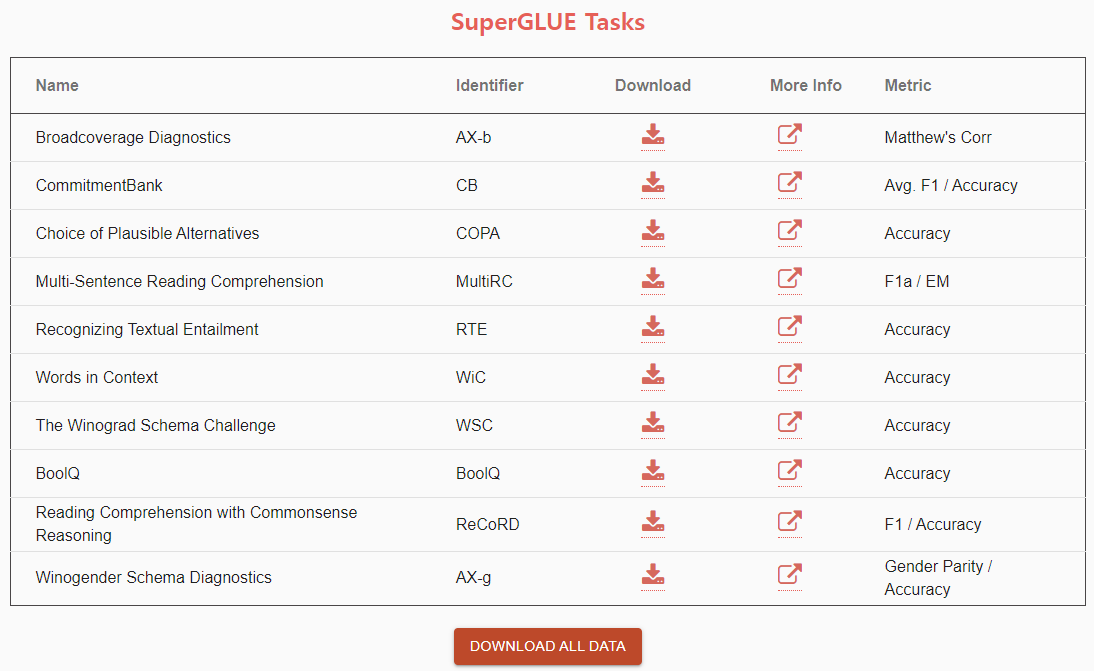

SuperGLUE

GLUE보다 어려운 NLU 태스크들과 더 나은 리소스 등을 추가한 벤치마크다.

GLUE가 sentence 그리고 sentence-pair classification에 국한된 반면에 SuperGLUE는 coreference resolution와 question answering (QA)를 포함한다.

또한 GLUE와는 달리 ethics와 commonsense reasoning도 포함되었다.

총 10개의 태스크로 구성된다.

Broadcoverage Diagnostics (AX-b)

GLUE의 Diagnostics Main과 같다.

CommitmentBank (CB)

담화 (discourses)의 마지막 문장의 취소 연산자 아래에 caluse-embdding을 포함한다고 한다.

취소 연산자 (canceling operator)란 질문 (question), 조동사 (modal), 부정 (negation), 조건문의 선행사 (antecendent of conditional)이다.

이런 대화의 맥락에서 프롬프트에 대한 예측을 7점 리커트 척도로 판단한다.

평가 metric은 Avg. F1와 Accuracy다.

Choice of Plausible Alternatives (COPA)

COPA는 open-domain commonsense causal reasoning을 다룬다고 한다.

즉 상식에 부합하는 인과추론을 평가한다.

평가 metric은 Accuracy다.

Multi-Sentence Reading Comprehension (MultiRC)

Reading Comprehension을 평가하기 위해 질문을 하면 정보를 잘 포함하는 답변을 찾도록 한다.

이때 단순히 정답에 가까운 최선의 답변을 찾는게 아니라 각각의 답변의 정확성을 평가한다.

평가 metric은 F1a와 EM이다.

F1a는 over all answer-options이고 EM은 exact match of each question's set of answers다.

SuperGLUE: A Stickier Benchmark for General-Purpose Language Understanding Systems 논문에서 참조했다.

Recognizing Textual Entailment (RTE)

GLUE의 RTE와 동일하다.

Words in Context (WiC)

Context-sensitive Word Embeddings를 평가하기 위한 데이터이며,

맥락 속에서의 단어의 뜻을 잘 찾는게 목적이다.

평가 metric은 Accuracy다.

The Winograd Schema Challenge (WSC)

GLUE의 WNLI와 동일하다.

BoolQ

yes/no 질문에 대한 QA 데이터다.

평가 metric은 Accuracy다.

Reading Comprehension with Commonsense Reasoning (ReCoRD)

Commonsense Reasoning에 관련된 데이터다.

즉 사람처럼 상식적인 추론을 가능한지를 측정하기 위한 데이터다.

평가 metric은 F1와 Accuracy다.

Winogender Schema Diagnostics (AX-g)

Automated coreference resolution systems에서 gender bais (젠더 편향)이 존재하는지 평가하기 위한 데이터다.

AI Ethics와 관련된 데이터다.

평가 metric은 Gender Parity와 Accuracy다.

MS의 Copilot에 물어보고 출처를 확인 결과, gender parity는 아래처럼 설명할 수 있다. It represents the percentage of minimal pairs (examples with gendered pronouns) for which the model’s predictions match.

즉 gendered pronouns가 적게 들어갈 수록 더 높은 수치를 가지며 따라서 더 높은 수치를 추구한다.

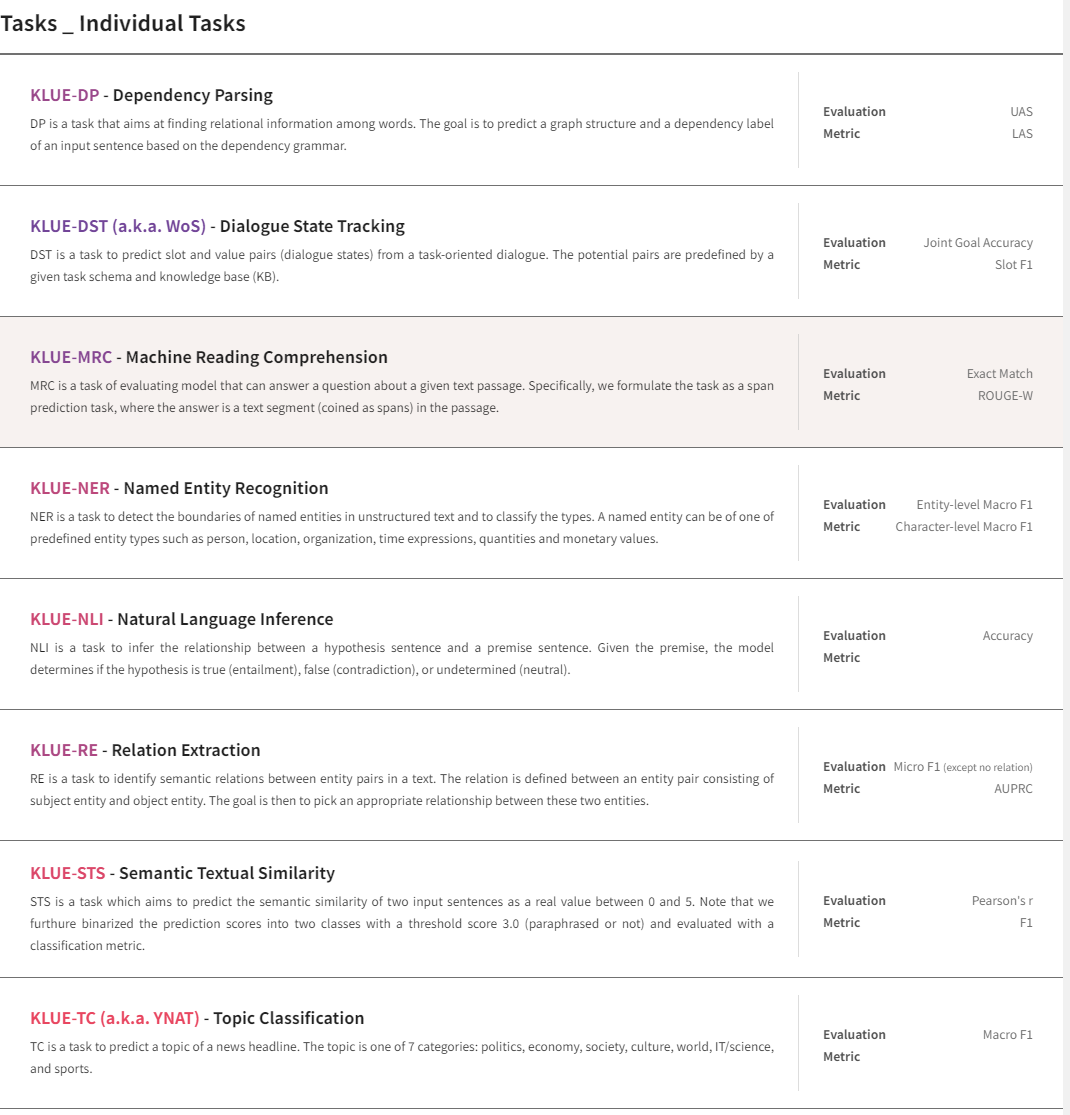

KLUE (Korean Language Understanding Evaluation)

클루는 한국어 버젼 글루다. 총 8개의 태스크로 구성되어 있다.

KLUE-DP

DP는 Dependency Parsing으로 한국어로 하면 의존 구문 분석이다.

문장 안에 있는 단어들이 어떻게 서로 연관이 되어 있는지를 알아내는 작업이다.

Evaluation metric으로 UAS와 LAS가 있는데 각각 다음과 같다.

UAS는 Unlabeled Atteachment Score, LAS는 Labeled Atteachment Score다.

UAS는 dependency만 확인하고 LAS는 dependency와 dependency의 label 모두를 확인한다.

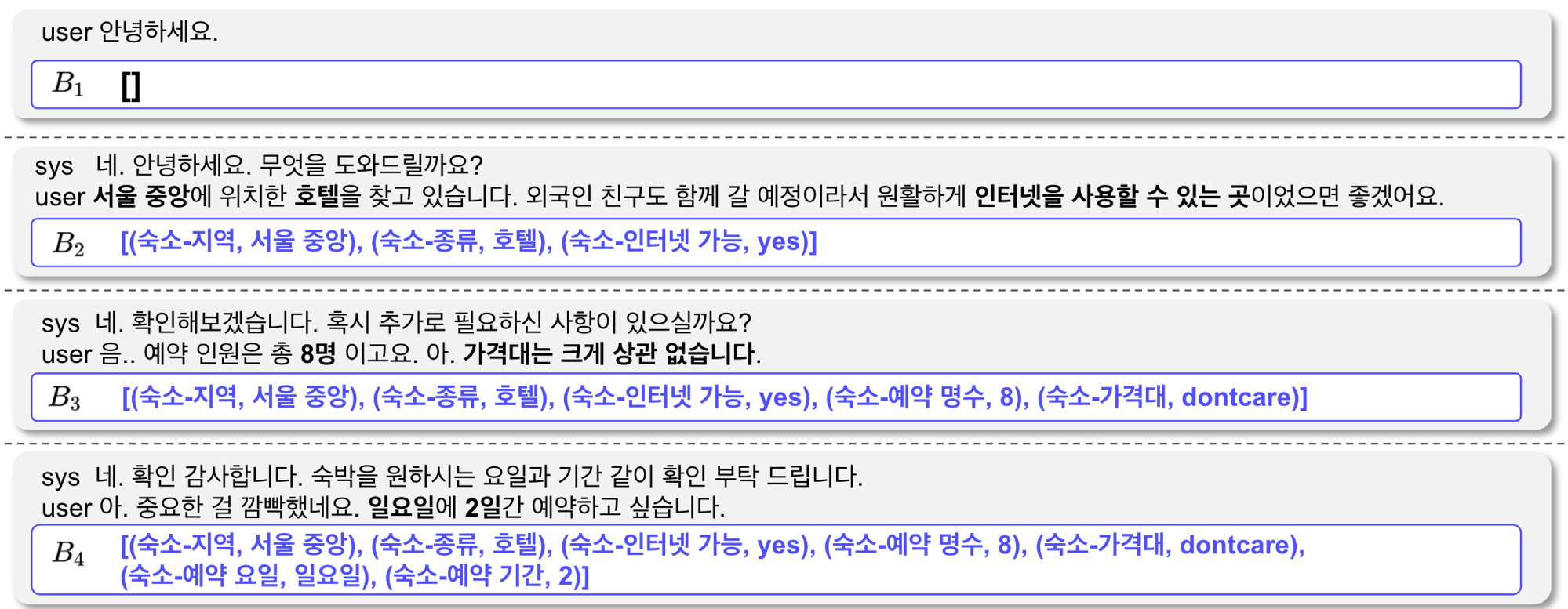

KLUE-DST (aks WoS)

DST는 Dialogue State Tracking로, 이는 현재 대화에서 유의미한 정보를 뽑아내어

특정한 상태(key)와 그 값(value)을 저장하는데 이를 얼마나 잘 저장하는지를 나타내는 지표다.

KLUE 사이트에서 가져온 아래 그림을 보면 이해가 쉬워진다.

평가 지표는 Joint Goal Accuracy (JGA)와 Slot F1 Score (Slot F1)이다.

JGA는 slot-value pairs가 잘 매치되는지를 평가하고, Slot F1은 slot-value pairs가 ground truth와 동일한지를 측정한다.

KLUE-MRC

MRC는 Machine Reading Comprehension으로 주어진 텍스트를 이해하고

그와 관련된 질문에 대해 적절한 답을 할 수 있는지로 평가한다.

KLUE-MRC에서는 paraphrase, multi-sentence reasoning, and unanswerable의 세 가지 질문을 한다.

평가 지표는 Exact Match와 ROUGE-W다.

ROGUE는 Recall-Oriented Understudy of Gisting Evaluation)으로 NLP 분야의

text summarization과 machine translation 등에 쓰이는 지표라고 한다.

BLEU가 Bilingual Evaluation Understudy Score로 n-gram에 기반한 precision 지표인데 반해,

ROGUE는 이름에서도 알 수 있듯이 n-gram에 기반한recall 지표다.

그중에서도 ROGUE-W는 Weighted Longest Common Subsequence라는 ROGUE의 variation에 해당한다.

가장 긴 연속적인 매칭에 가중치를 주는 방법론이다.

KLUE-NER

NER은 Named Entity Recognition으로 개체명 인식이다. 보통 인물, 단체, 장소, 전문용어 등이 대상이다.

KLUE-NER에서는 person(PS), location(LC), organization(OG), date(DT), time(TI), and quantity(QT)의 여섯 가지를 다룬다.

또한 BIO (Begin-Inside-Outside) tagging scheme을 사용한다.

평가 지표로는 entity-level macro F1와 character-level macro F1 scores을 사용한다.

KLUE-NLI

NLI는 Natural Language Inference로 RTE (Recognizing Textual Entailment)와 동일하다.

주어진 premise에 대해 NLI 모델은 hypothesis이 true (entailment)인지 false (contradiction)인지 undetermined (neutral)인지를 결정하게 된다.

평가 지표는 accuracy다.

KLUE-RE

RE는 Relation Extraction으로 entity pair의 semantic relation 의미 관계를 알아내는 작업이다.

Kierkegaard was born to an affluent family in Copenhagen란 문장이 있을 때,

subject entity는 `Kierkegaard’ 이고 object entity는 `Copenhagen’이며 목표는 둘 사이의 관계 파악이다.

이때 정답은 place_of_birth다.

주어진 두 entity의 pair를 관계까지 합친 triple로 알아내게 되며,

30개의 relation class로 이루어지는데, 18개의 person-related, 11개의 organization-related,

1개의 no_relation으로 구성된다.

평가 지표는 no_relation을 제외한 micro-F1 score이며,

no_relation을 포함한 30개 클래스에 대한 AUPRC 커브 또한 사용한다.

KLUE-STS

STS는 Semantic Textual Similarity이며 두 문장 사이의 semantic euivalence, 즉 의미적으로 얼마나 유사한지 찾는다.

STS는 Machine Translation, Summurization, QA에 있어서 중요한 벤치마크다.

GLUE같은 많은 NLU 벤치마크들은 semantic similarity, paraphrase detection, word sense disambiguation을 포함한다.

Stentence pair의 데이터를 0점 부터 5점까지 측정한다.

추가적으로 threshold를 3.0으로 잡아서 그 이상이면 parapharsed로, 3.0 미만이면 not paraphrased로 분류한다.

평가 지표는 F1 score다.

KLUE-TC (aka YNAT)

TC는 Topic Classification으로 주어진 text snippet에 대해 주제를 예측한다.

보통 single sentence classification을 하는 관습에 따라 YNAT를 도입해서 측정한다.

YNAT란 Younhap News Agency news headlines for Topic Classification이다.

뉴스 헤드라인의 주제는 politics, economy, society, culture, world, IT/science, sports다.

평가 지표로는 Macro-F1 score를 사용한다.

Huggingface Open LLM Leaderboard

Pretrained PyTorch 모델들의 가장 유명한 라이브러리인 huggingface의 LLM 리더보드에 대해서도 간략하게 정리했다.

최근 업스테이지에서 나온 SOLAR가 좋은 성능을 냈다고 해서 궁금해진 벤치마크다.

자세한 내용은 Open LLM Leaderborad의 About을 보면 알 수 있다.

허깅페이스에서는 Eleuther AI Language Model Evaluation Harness를 통한 6개의 key benchmarks를 이용해 generative language model을 테스트 한다고 한다.

AI2 Reasoning Challenge (25-shot)

a set of grade-school science questions.

= 초등 과학 문제들

HellaSwag (10 shot)

a test of commonsense inference, which is easy for humans (~95%) but challenging for SOTA models.

= 상식이 있는 추론

MMLU (5 shot)

a test to measure a text model's multitask accuracy. The test covers 57 tasks including elementary mathematics, US history, computer science, law, and more.

= 초등수학, 미국역사, 컴퓨터과학, 법 그외의 다양한 텍스트를 활용한 NLU 태스크다.

TruthfulQA (0 shot)

- a test to measure a model's propensity to reproduce falsehoods commonly found online. Note: TruthfulQA is technically a 6-shot task in the Harness because each example is prepended with 6 Q/A pairs, even in the 0-shot setting.

= 온라인에서 흔히 발견되는 거짓을 테스트. AI가 생성한 답변이 얼마나 진실한지를 측정한다고 한다.

Winogrande (5-shot)

an adversarial and difficult Winograd benchmark at scale, for commonsense reasoning.

= 상식 있는 추론

GSM8k (5-shot)

diverse grade school math word problems to measure a model's ability to solve multi-step mathematical reasoning problems.

= 수학적인 논리 추론

한국어 버젼인 Open Ko-LLM Leaderboard도 있는데 Upstage, NIA, 한국 AI Hub가 같이 만들었다고 한다.

References:

https://gluebenchmark.com/tasks

https://gluebenchmark.com/leaderboard

https://gluebenchmark.com/diagnostics

https://paperswithcode.com/dataset/glue

https://velog.io/@raqoon886/GLUE

https://choice-life.tistory.com/82

https://cims.nyu.edu/~sbowman/multinli/

https://ratsgo.github.io/nlpbook/docs/pair_cls/overview/

https://super.gluebenchmark.com/

https://paperswithcode.com/dataset/superglue

https://en.wikipedia.org/wiki/Phi_coefficient

https://paperswithcode.com/dataset/qnli

https://cogcomp.seas.upenn.edu/multirc/

SuperGLUE: Understanding a Sticky Benchmark for LLMs | Deepgram

https://velog.io/@tobigs1617text/CS224n-Lecture-4-Dependency-Parsing

https://supkoon.tistory.com/26

https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard

https://huggingface.co/spaces/upstage/open-ko-llm-leaderboard

https://www.aihub.or.kr/leaderboard/view.do?currMenu=500&topMenu=102

'NLP' 카테고리의 다른 글

| LSTM 모델 설명과 PyTorch Implementation (0) | 2024.04.09 |

|---|---|

| 딥러닝 기반 NLP 모델들 (0) | 2024.03.06 |

| 자연어처리 (NLP) 기초 (0) | 2024.02.29 |

| LLM Models and Applications (0) | 2024.02.23 |

| 눈여겨 볼만한 NLP 모델들 (0) | 2024.01.31 |