Transformer 이후 이에 기반한 많은 모델들이 나왔고 LLM까지 등장했다.

LLM은 모델도 크고, 데이터도 크기 때문에 개인이나 소규모 기업들이 직접 학습시키기 어렵다.

하지만 LLM은 GLUE에서 좋은 성능을 거두는 경우도 많고, 오픈소스인 경우도 많아서

직접 모델을 학습할 수 없는 사람이나 집단은 pretrained model을 가져와서

tuning하거나 transfer learning의 방법으로 각자의 문제를 풀 수 있게 되었다.

따라서 이런 PLM (Pretrained Langauge Model)을 아는 것은 중요하다.

기본적으로 Transformer는 Multi-head Attention과 Self-Attention, Encoder, Decoder 구조를 지니고 있다.

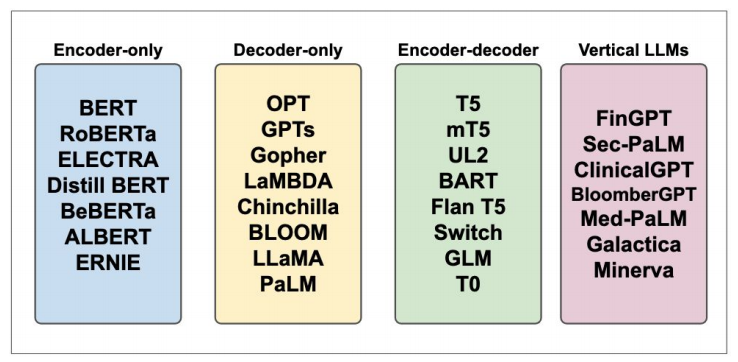

여기서 Encoder만 활용한 모델, Decoder만 활용한 모델 Encoder와 Decoder를 모두 활용한 모델 등으로 갈라지게 된다.

Transformer 모델의 attention이나 encoder, decoder 내용은 여기를 참고하면 좋다.

PyTorch에서 구현한 코드를 자세하게 분석한 블로그도 참조하면 좋다.

BERT (Bidirectional Encoder Representations from Transformers)는 대표적인 인코더 구조 모델이다.

BERT는 MLM(Masked Language Modeling)과 NSP(Next Sentence Prediction)으로 학습한 모델이다.

Encoder 모델은 양방향으로 학습하기 때문에 텍스트의 이해에 적합하다.

여러 NLP 태스크 중에서 문장분류, 클러스터링, NER, QA 등에 많이 쓰인다.

BERT의 소스 코드 분석은 이 블로그를 많이 참조했다.

GPT-2(Generative Pretrained Transformer 2)를 비롯한 GPT 시리즈는 대표적인 디코더 구조 모델로 생성에 강하다.

GPT-2는 CLM (Causal Language Modeling)의 태스크를 이용해 학습한 모델이다.

Decoder 모델은 한쪽 방향으로 학습하며, 생성에 적합한 모델이다.

Andrej Karpathy의 Nano GPT를 참조해서 Pre-training부터 학습하는 코드를 많이 공부했다.

Reproduce GPT-2 영상이 4시간 짜리가 있는데 이 링크를 참고해도 좋다.

BART (Bidirectional Auto Regressive Transformers)는 인코더 디코더 구조 모델이다.

BERT처럼 양방향을 모두 고려하지만 GPT처럼 단방향으로 예측하는 특성도 포함하고 있다.

이 GPT처럼 학습하는 특성을 Auto Regressive라고 여기서는 명명한다.

대규모 Seq2Seq 학습 모델로, 임의로 변형된 문서를 되돌리는 denoising autoencoder 구조를 지닌다.

Encoder-Decoder 모델은 양쪽 방향 학습과 한쪽 방향 학습 모두 있기 때문에

입력과 출력 모두 중요한 Machine Translation, QA, Summarization에 쓰인다.

딥러닝 기반 NLP 응용분야

형태소 분석과 품사 태깅

카카오의 Khaiii

Character-Level Bidirectional LSTM-CRF

의미역 분석

BERT와 LSTM-CRF 동시 사용

개체명 인식 (NER)

Transformer 기반

RNN 기반

질의응답(QA)와 Machine Reading Comprehension (MRC)

Dense Passage Retrieval

Information Retrieval (IR) to Reader

Siamese Networks

Bidirectional Attention Flow QA

Compare-Aggregate Network QA

NMT (Neural Machine Translation, 신경망 기반 기계 번역)

Transformer

Text Extraction and Summarization

BART

KoBART

BERTSum

STEP (Sequence-To-Sequence Pre-training)

PEGASUS (Pre-training with Extracted Gap-sentences for Abstractive Summarization)

Diaglogue System

Task-Oriented Dialouge (TOD) vs Open-domain Dialogue (ODD)

TOD-BERT

Text Generation

GPT

References:

[업스테이지] AI 심화 학습 - NLP

https://huggingface.co/blog/long-range-transformers

https://tech.kakao.com/2018/12/13/khaiii/

https://www.letr.ai/blog/tech-20210730

https://velog.io/@changyong93/5%EA%B0%95-Passage-Retrieval-Dense-Embedding

https://www.samsungsds.com/kr/insights/techtoolkit_2021_qa.html

https://velog.io/@jeewoo1025/ACL2020-Tutorial-Open-Domain-Question-Answering-ver3

https://kicarussays.tistory.com/42

https://vaclavkosar.com/ml/Encoder-only-Decoder-only-vs-Encoder-Decoder-Transfomer

'NLP' 카테고리의 다른 글

| GRU 모델 설명 (0) | 2024.04.11 |

|---|---|

| LSTM 모델 설명과 PyTorch Implementation (0) | 2024.04.09 |

| 자연어처리 (NLP) 기초 (0) | 2024.02.29 |

| LLM Models and Applications (0) | 2024.02.23 |

| 눈여겨 볼만한 NLP 모델들 (0) | 2024.01.31 |