최근 AI 모델, 특히 딥러닝 모델의 크기는 점점 커지고 있으며

GPU 메모리는 유한하기 때문에 모델의 메모리 요구량을 계산해봐야 한다.

Floating Point and Memory

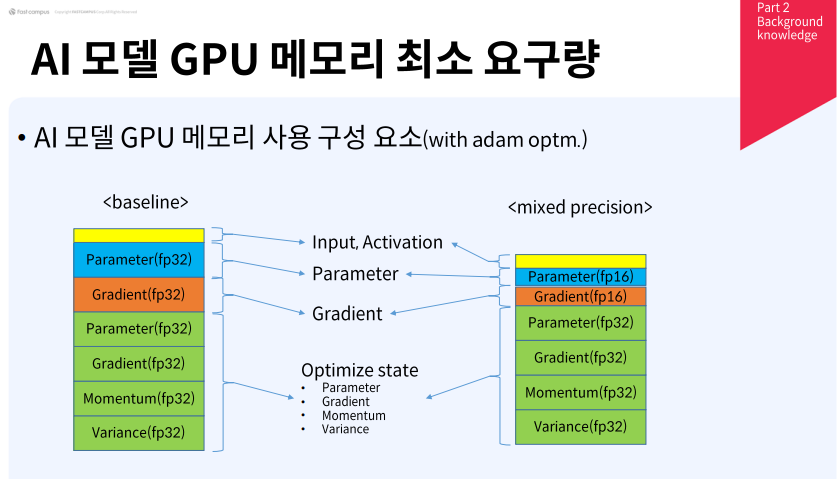

Parameter: 모델의 파라미터

Input, Activaiton: Forward 했을 때의 각 레이어의 결과 값들

Gradient: Backward에서 사용할, 계산된 그라디언트 값. Mixed Precision의 경우 FP16으로 연산, 저장은 FP32로 한다.

Optimizer state

- Parameter: 모델 파라미터

- Gradient: 모델의 업데이트를 위한 그라디언트

- Momentum: 옵티마이저가 모멘텀을 업데이트 하기 위해 필요한 메모리

- Variance: 옵티마이저의 Variance를 업데이트 하기 위해 필요한 메모리

fp32는 32bit floating point로 Exponent 8 bits와 Mantissa 23 bits가 있다.

나머지 1 bit는 sign으로 양수와 음수를 나타낸다.

fp16은 16bit로 Exponent가 5 bits, Mantissa가 10 bits, 1 bit가 sign이다.

Input, Activation, Parameter, Gradient, Optimize State (Adam의 경우 Parameter, Gradient, Momentum, Variance)를 모두 fp32로 나타낼 수도 있고, Optimizer가 아닌 파트는 fp16으로 나타내는 mixed precision을 사용할 수도 있다.

Calculating Memory Requirement

Convolution Case

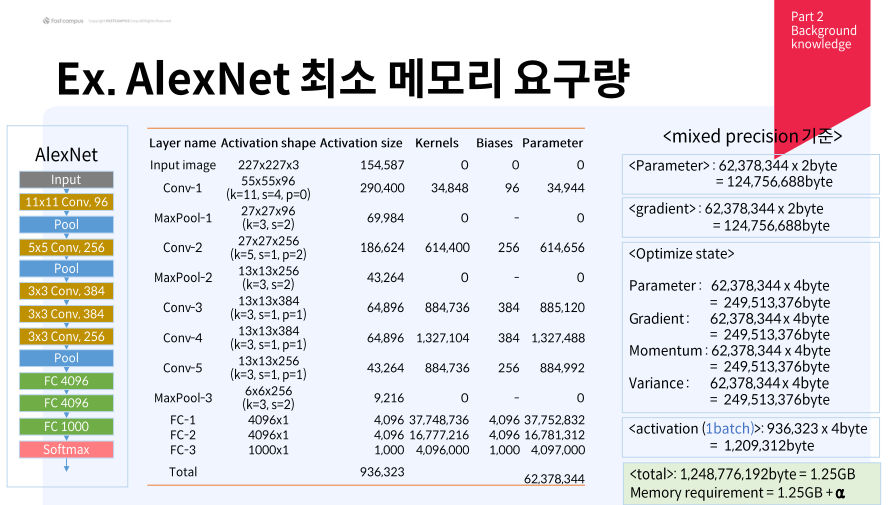

Conv-1의 경우 11x11x3x96 = 34,848, 그리고 새로이 변환된 Channel의 개수만큼인 96개의 biases가 추가되어 34,944개의 Parameters를 가진다.

계산해보면 1.25 GB + $\alpha$만큼의 용량이 필요하다.

총 메모리 할당 크기 =

Parameter의 메모리 요구량 + Activation의 메모리 요구량 + Optimize State의 메모리 요구량 + $\alpha$.

이때, Parameter의 크기 = Gradient의 크기 = Momentum의 크기 = Variance의 크기다.

따라서,

Optimize State의 크기 = 4 x Parameter의 크기다.

Parameter의 크기 x 2 bytes + Gradient의 크기 x 2 bytes + Optimize State의 크기 x 4 bytes + Activation의 크기 x 4 bytes

= Parameter의 크기 x 20 bytes + Activation의 크기 x 4 bytes + $\alpha$.

Attention Case

최근 LLM이나 Computer Vision 분야에서 많이 쓰이는 Attention 구조의 경우 세는 방법이 약간 다르다.

SK DEVOCEAN의 GPT 모델 크기 계산 방법 (링크)과 Scaling Law for LM 내용 (논문링크, 블로그링크) 을 참고해서 계산하면 다음과 같다.

우선 $d_{attn}$ = $d_{model}$ = $d_{ff} / 4$다.

따라서 embed size는 ($n_{vocab}$ + $n_{ctx}$) $d_{model}$이다.

QKV multi head attention에서의 파라미터 수는 $n_{layer} \cdot d_{model} \cdot 3 d_{attn}$이다.

Q, K, V의 dim이 각각 $d_{attn}$ 이기 때문이다.

Attention-Project는 Multi-head attention을 수행한 결과를 다시 MLP를 수행한 결과다.

따라서 $n_{layer} \cdot d_{attn} \cdot d_{model}$ 만큼의 파라미터 개수가 필요하다.

Feedforard는 MLP를 2번 수행하므로 $n_{layer} \cdot 2 d_{model} \cdot 3 d_{ff}$다.

이를 모두 합하면 N이 된다.

N = $n_{layer} \cdot d_{model} \cdot 3 d_{attn} + n_{layer} \cdot d_{attn} \cdot d_{model} + n_{layer} \cdot 2 d_{model} \cdot 3 d_{ff}$

$\approx 12 \cdot n_{layer} \cdot {d_{model}}^2$다.

Examples of Memory Requirement

AlexNet의 경우 약 61M parameters다. 따라서 61 x 100,000 x 20 + $\alpha$ = 1.22 GB + $\alpha$

CoAtNet-7은 약 2240M parameters이므로 2,240 x 100,000 x 20 + $\alpha$ = 44.8 GB + $\alpha$

GPT3는 약 175B parameters이므로 175 x 100,000,000 x 20 + $\alpha$ = 3.5 TB + $\alpha$

AlexNet 같은 비교적 예전 모델의 경우 4 GB도 안되는 작은 용량이지만,

CoAtNet-7 같은 경우 약 45 GB가 넘어서 VRAM이 24G인 RTX 3090이나 4090으로도 돌리기 힘들다.

GPT3 같은 거대한 모델의 경우 TB 단위라서 개인이 모델을 학습시키기 어렵다.

심지어 개인 워크스테이션으로 RTX A6000 D6 48 GB를 4개를 써도 불가능하다.

최근 모델들, 특히 NLP모델의 경우 엄청나게 많은 메모리와 GPU가 필요하기 떄문에,

리소스가 충분한 개인이나 집단이 아니라면 거대 모델의 Pre-trained Model을 가져와서

Fine-Tuning하거나 Transfer Learning하는 작업이 필수적이다.

출처:

패스트 캠퍼스의 실무 사례로 배우는 컴퓨터 비전 논문 구현과 알고리즘 성능 최적화 With SOTA 모델 강의를 참조

https://devocean.sk.com/blog/techBoardDetail.do?ID=165306

https://tutorials.pytorch.kr/intermediate/optimizer_step_in_backward_tutorial.html

'Deep Learning' 카테고리의 다른 글

| Floating-point Number와 Mixed Precision (0) | 2025.04.29 |

|---|---|

| Meta, Few-shot, Zero-shot, Active Learning (0) | 2024.10.25 |

| 딥러닝 모델 분석과 구현 정리 (0) | 2024.04.24 |

| Tensorboard and WandB (0) | 2024.03.29 |

| 알아두면 좋은 주요 딥러닝 모델들 (0) | 2024.02.22 |