Chinchilla (2022) 논문 리뷰

Chinchilla 모델이 등장한 논문의 이름은 Training Compute-Optimal Large Language Models다(링크) 저자는 Jordan Hoffmann, Sebastian Borgeaud, Arthur Mensch, Elena Buchatskaya, Trevor Cai, Eliza Rutherford, Diego de Las Casas, Lisa Anne Hendricks, Johannes Welbl, Aidan Clark, Tom Hennigan, Eric Noland, Katie Millican, George van den Driessche, Bogdan Damoc, Aurelia Guy, Simon Osindero, Karen Simonyan, Erich Elsen, Jac..

2025. 4. 11.

Chinchilla (2022) 논문 리뷰

Chinchilla 모델이 등장한 논문의 이름은 Training Compute-Optimal Large Language Models다(링크) 저자는 Jordan Hoffmann, Sebastian Borgeaud, Arthur Mensch, Elena Buchatskaya, Trevor Cai, Eliza Rutherford, Diego de Las Casas, Lisa Anne Hendricks, Johannes Welbl, Aidan Clark, Tom Hennigan, Eric Noland, Katie Millican, George van den Driessche, Bogdan Damoc, Aurelia Guy, Simon Osindero, Karen Simonyan, Erich Elsen, Jac..

2025. 4. 11.

LaMDA (2022) 논문 리뷰

LaMDA 모델의 논문 이름은 LaMDA: Language Models for Dialog Applications다. (링크) 저자는 Romal Thoppilan, Daniel De Freitas, Jamie Hall, Noam Shazeer, Apoorv Kulshreshtha, Heng-Tze Cheng, Alicia Jin, Taylor Bos, Leslie Baker, Yu Du, YaGuang Li, Hongrae Lee, Huaixiu Steven Zheng, Amin Ghafouri, Marcelo Menegali, Yanping Huang, Maxim Krikun, Dmitry Lepikhin, James Qin, Dehao Chen, Yuanzhong Xu, Zhifeng Chen, A..

2025. 4. 11.

LaMDA (2022) 논문 리뷰

LaMDA 모델의 논문 이름은 LaMDA: Language Models for Dialog Applications다. (링크) 저자는 Romal Thoppilan, Daniel De Freitas, Jamie Hall, Noam Shazeer, Apoorv Kulshreshtha, Heng-Tze Cheng, Alicia Jin, Taylor Bos, Leslie Baker, Yu Du, YaGuang Li, Hongrae Lee, Huaixiu Steven Zheng, Amin Ghafouri, Marcelo Menegali, Yanping Huang, Maxim Krikun, Dmitry Lepikhin, James Qin, Dehao Chen, Yuanzhong Xu, Zhifeng Chen, A..

2025. 4. 11.

OPT (2022) 논문 리뷰

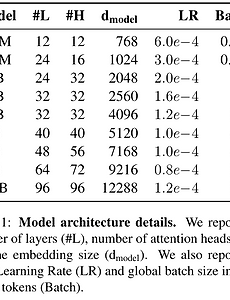

OPT의 논문 이름은 OPT: Open Pre-trained Transformer Language Models다. (링크) 저자는 Susan Zhang, Stephen Roller, Naman Goyal, Mikel Artetxe, Moya Chen, Shuohui Chen, Christopher Dewan, Mona Diab, Xian Li, Xi Victoria Lin, Todor Mihaylov, Myle Ott, Sam Shleifer, Kurt Shuster, Daniel Simig, Punit Singh Koura, Anjali Sridhar, Tianlu Wang, Luke Zettlemoyer다. 메타 (페이스북)에서 공개한 오픈 소스 Decoder LLM 모델이다. AbstractO..

2025. 4. 11.

OPT (2022) 논문 리뷰

OPT의 논문 이름은 OPT: Open Pre-trained Transformer Language Models다. (링크) 저자는 Susan Zhang, Stephen Roller, Naman Goyal, Mikel Artetxe, Moya Chen, Shuohui Chen, Christopher Dewan, Mona Diab, Xian Li, Xi Victoria Lin, Todor Mihaylov, Myle Ott, Sam Shleifer, Kurt Shuster, Daniel Simig, Punit Singh Koura, Anjali Sridhar, Tianlu Wang, Luke Zettlemoyer다. 메타 (페이스북)에서 공개한 오픈 소스 Decoder LLM 모델이다. AbstractO..

2025. 4. 11.